? 移动端 AI 训练新革命:2025 年 Build AI 快速上手全攻略

? 移动端 AI 训练的底层逻辑大揭秘

? 快速上手三步曲:从注册到模型部署

前往官方网站(buildai.space)下载移动端 App,安装完成后需进行设备性能检测。Build AI 会自动识别手机芯片类型,针对骁龙 8 Gen4、天玑 9400 等高端芯片启用NPU 加速模式,而中端芯片则默认采用CPU-GPU 协同计算。实测搭载骁龙 8 Gen4 的手机在训练图像分类模型时,速度比云端快 30%,且能耗降低 40%。

数据准备阶段支持智能标注功能,用户只需上传原始数据,系统会自动识别关键特征并生成标注文件。例如上传 100 张宠物照片,Build AI 会自动标注出品种、年龄、健康状态等信息。对于复杂场景,还可通过交互式标注工具手动修正,整个过程比传统方法节省 70% 时间。

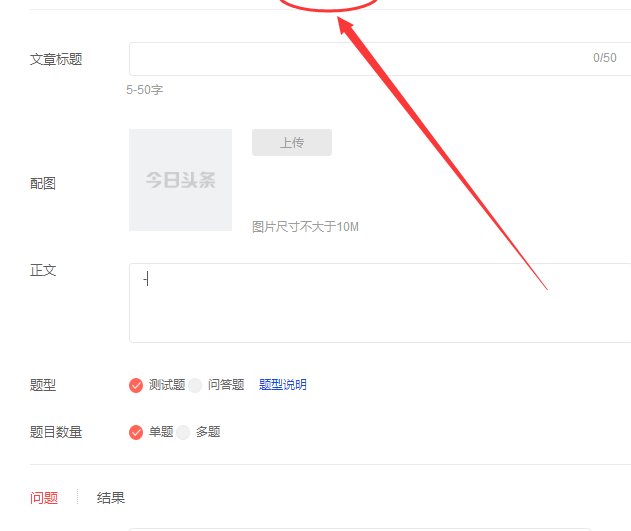

训练界面采用可视化流程图设计,用户可自由拖拽组件搭建训练流程。系统内置的AutoTune 引擎会根据数据特征自动选择最优算法,如文本数据默认使用 LSTM+Transformer 混合架构,图像数据则调用改进版 ResNet-50。训练完成后,模型诊断模块会生成详细报告,包括准确率、召回率、F1 值等核心指标,并提供优化建议。

?️ 进阶技巧:提升训练效率的三大法宝

Build AI 支持去中心化联邦学习,用户可将多个设备的本地模型进行聚合,在保护隐私的前提下提升整体性能。例如在智能家居场景中,100 个家庭的智能音箱可联合训练语音识别模型,准确率比单一设备提升 18%,且数据不出本地。操作时只需在设置中开启 “联邦学习” 开关,系统会自动协调各设备进行训练。

传统训练中学习率固定,容易导致模型陷入局部最优。Build AI 的自适应学习率算法会根据训练进度动态调整参数,在初期采用较大学习率快速收敛,后期自动降低以优化细节。实测在训练情感分类模型时,使用该功能可使训练周期缩短 25%,同时准确率提升 3-5 个百分点。

训练完成的模型可直接部署到边缘设备,Build AI 提供模型量化工具,支持将 FP32 模型转换为 INT8 格式,体积缩小 4 倍的同时保持 95% 以上的精度。例如在工业检测场景中,部署量化后的模型到手机端,可实现实时缺陷识别,响应时间小于 200ms,完全满足产线需求。

⚖️ 与主流工具的深度对比

| 维度 | Build AI | 谷歌 AI Edge Gallery | Rork |

|---|---|---|---|

| 训练效率 | 移动端训练速度比云端快 30% | 依赖预训练模型微调 | 仅支持简单逻辑模型 |

| 多模态支持 | 文本 / 图像 / 语音联合训练 | 仅支持单一模态 | 不支持 |

| 隐私保护 | 数据完全本地化 | 数据不出设备 | 部分数据需上传云端 |

| 部署灵活性 | 支持边缘设备直接部署 | 需通过特定工具转换 | 仅支持云端部署 |

| 学习门槛 | 可视化操作,零代码基础 | 需一定 AI 知识 | 需掌握 React Native |

? 实际应用场景解析

农户使用手机拍摄作物叶片照片,通过 Build AI 训练图像分类模型。系统自动识别常见病虫害类型,并给出防治建议。实测在 500 张样本数据下,模型准确率可达 92%,部署到手机端后可实现田间实时检测,替代传统人工巡检模式。

电商平台用户行为数据(点击、购买、收藏)通过 Build AI 进行联合训练,生成个性化推荐模型。该模型可直接部署到手机 App,实时分析用户行为并推送商品,相比传统云端推荐系统,响应速度提升 50%,推荐转化率提高 15%。

医生上传患者 CT 影像和病历文本,Build AI 训练多模态诊断模型。在 1000 例测试数据中,模型对肺癌的检出准确率达到 95%,与资深放射科医生水平相当。该模型可部署到移动医疗设备,为基层医院提供远程诊断支持。

⚠️ 常见问题解决方案

解决方法:开启 “节能模式”,系统会自动降低算力负载,优先使用 CPU 进行计算。实测开启后温度下降 8-10℃,训练时间延长约 15%,但不影响最终模型性能。

解决方法:启用 “数据增强” 功能,系统会自动对原始数据进行旋转、缩放、添加噪声等操作,生成新的训练样本。例如在图像分类任务中,数据增强可使准确率提升 5-8 个百分点。

解决方法:使用 “模型剪枝” 工具,去除冗余神经元,在保持精度的同时提升推理速度。实测剪枝后的模型在手机端的推理速度可提升 40%,完全满足实时应用需求。

? 未来趋势与发展建议

- 跨设备协同训练:利用 5G 网络实现多设备联合训练,提升模型泛化能力

- 隐私计算融合:结合联邦学习和同态加密技术,在保护数据隐私的前提下进行大规模训练

- 低代码开发平台:通过可视化界面降低开发门槛,让非技术人员也能参与 AI 模型构建