AI 文本检测工具的核心是数据驱动。像朱雀大模型检测这类工具,会通过分词、句法分析提取词汇集中度、句子长度分布等特征,还会计算文本 “困惑度”——AI 生成内容往往逻辑过于完美、用词平滑,导致 “困惑度” 低。复旦大学团队提出的 ImBD 框架更绝,先模仿机器写作风格,捕捉 “stunning”“once-in-a-lifetime” 这类高频词和复杂句式,再通过 “风格条件概率曲线” 量化偏离程度,检测 GPT-4 修改的文本准确率提升近 20%。

南方都市报用四类文本测试 10 款工具,结果让人跌破眼镜:老舍《林海》被茅茅虫误判为 99.9% AI 生成,万方将 1300 字中的 500 字标为 AI;而 AI 生成的《林海》散文,知网、挖错网等却漏检,AI 率仅 0%-2%。这暴露出三大问题:真实内容误判多、AI 内容漏检率高、检测标准不统一。

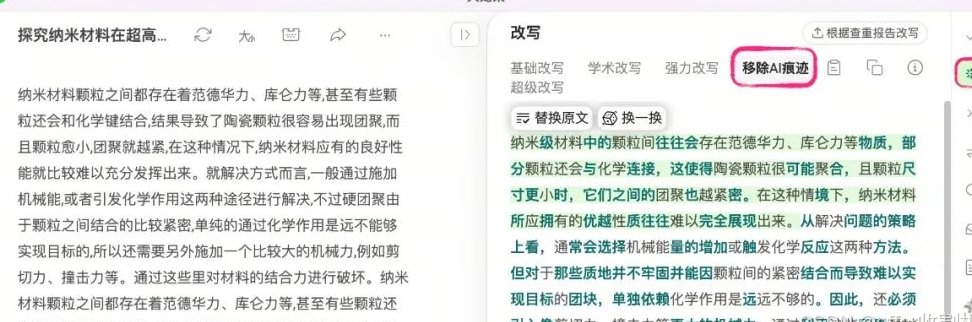

学术圈最卷。图灵论文 AI 写作助手允许每日无限次检测,能标记原始 AI 段落和人工修饰内容,还能通过替换近义词(如 “应用场景”→“实施范畴”)、调整句式(主动语态→被动语态)降低 AI 率,实测将 35% 相似度的文献综述降至 8%。MitataAI 检测器更绝,支持 12 个专业模型,检测法学论文时能保留术语,处理文学评论又能彻底重构韵律,混合使用多个 AI 工具生成的文本也能被揪出 42% 的 AI 参与度。

免费工具如 MitataAI、图灵助手,功能全面但缺少定制化服务;付费工具中,Turnitin 国际版月费约 $10,但对中文混合内容检测延迟明显;知网 AIGC 检测按字数收费,适合终稿验证但费用较高。性价比最高的是腾讯混元团队的朱雀检测,中文检测准确率超国外工具,还能同时识别图像,企业版可按需定制。

9 月 1 日实施的《人工智能生成合成内容标识办法》要求构建 “显式 + 隐式” 双层标识体系,这意味着 AI 工具需与官方标识系统兼容,检测不再是单纯的技术问题。技术层面,ImBD 这类 “先模仿后检测” 的框架可能成为主流,毕竟仅需 1000 个样本、5 分钟训练就能超越 GPTZero。而传统方法会更依赖人机协同,比如某金融平台在 AI 初筛后,由专家审核存疑内容,误判率从 11.47% 进一步降至 5% 以下。

🔗立即免费注册 开始体验工具箱 - 朱雀 AI 味降低到 0%- 降 AI 去 AI 味