📊 实测数据:文学经典与 AI 生成内容的对抗

🚧 误报的三大「雷区」

文学作品常用比喻、排比等手法,这些在 AI 生成内容中也很常见。比如某学科论文中,人工撰写的段落因为逻辑严谨、句式工整,被朱雀误判为 AI 生成的概率较高。这是因为 AI 模型在训练时,可能将「语言规范」等同于「AI 生成」,导致优质的人类写作反而触发警报。

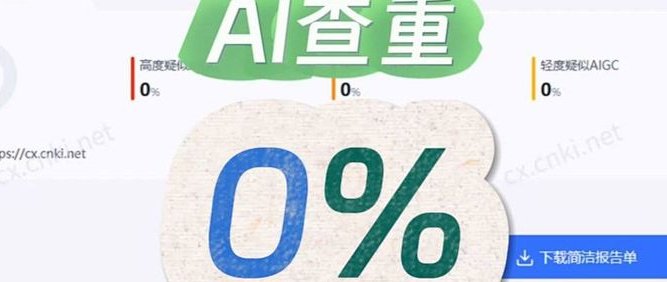

网文作者荷桃粥测试自己的小说时发现,不同章节的检测结果差异很大:第 1 章显示 0%,第 40 章却高达 87%。推测可能是因为后期章节加入了更多内心描写和跳跃性叙事,这些在 AI 生成内容中较少见,反而让模型产生怀疑。这也说明,写作风格的变化可能影响检测准确性。

学术论文因为引用规范、逻辑严密,容易被误判。中国人民大学一位副教授的论文中,耗时 3 年调研的内容被标红为「高度疑似 AI 生成」。这暴露了 AI 检测在学术场景中的局限性 —— 越是符合规范的表达,越可能被误认为是 AI 生成。

🔍 误判根源:技术逻辑与人类创作的冲突

如果模型训练时使用的文学作品样本不足,可能无法识别某些特定风格。比如诗歌的押韵和意象,在 AI 生成内容中较少见,检测模型可能将其视为「异常」。

为了减少漏检,部分模型会设置较高的敏感度,导致正常文本被误判。例如,含 20% AI 内容的假新闻,茅茅虫等工具识别率过高,而知网、维普等又偏低。朱雀在这类场景中表现相对平衡,但仍有优化空间。

方文山推荐文的案例显示,删除标题和作者信息后,检测结果大幅下降。这说明模型可能过度依赖文本的外部信息,而非内容本身的特征。如果用户刻意隐藏某些线索,检测结果可能失真。

📌 降低误判的实用建议

- 适当加入口语化表达或「不完美」的句子,比如偶尔使用重复词或轻微语法错误,降低「AI 感」。

- 避免连续使用复杂句式,长短句交替能让文本更自然。

- 文学创作可以先用朱雀检测,再结合其他工具(如鉴字源)交叉验证。

- 学术论文建议参考知网、团象等更侧重专业领域的工具。

- 部分内容平台(如微博、微信视频号)要求 AI 生成内容必须声明,主动标注可以避免误判。

- 如果被误判,可向平台提供创作过程的证据(如历史文档、修改记录),帮助人工复核。

🌟 朱雀的优势与行业启示

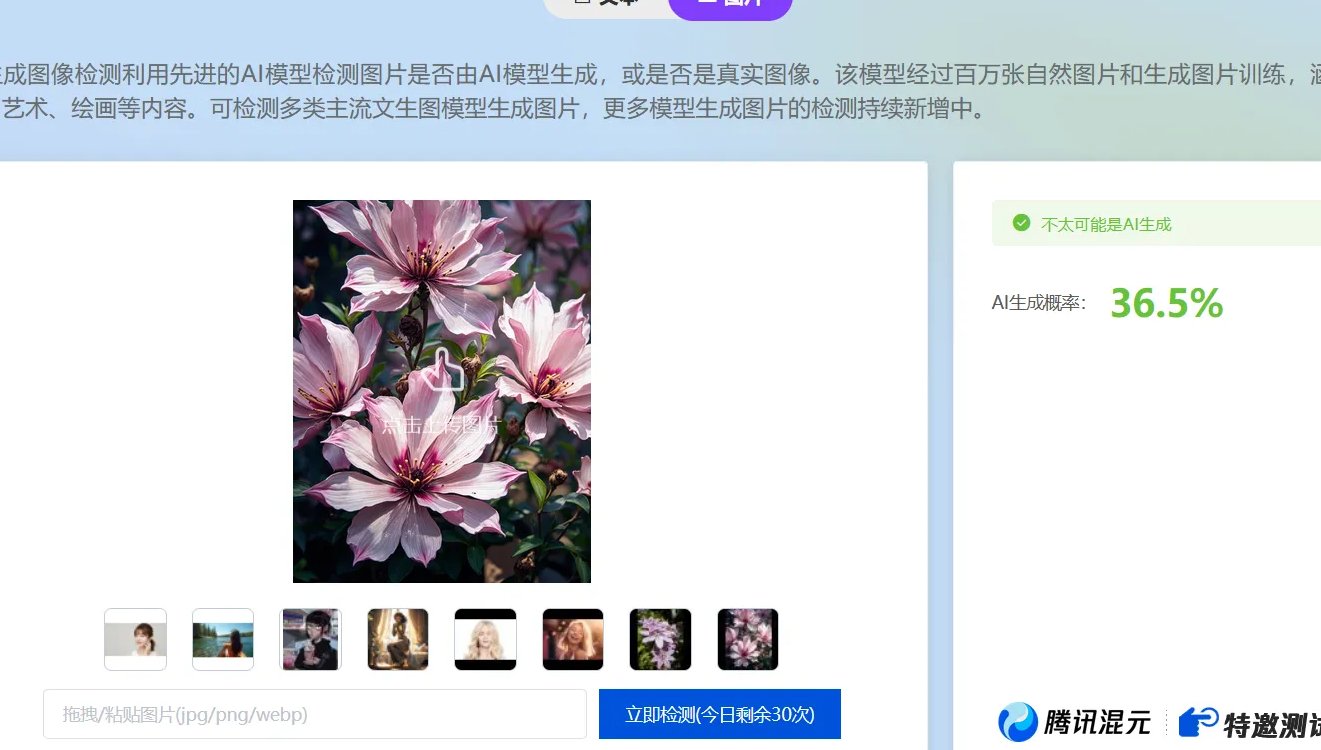

除了文本,朱雀还能检测图片,对原始摄影图的识别准确率较高,但对 PS 修改图仍有难度。这种综合能力在同类工具中少见。

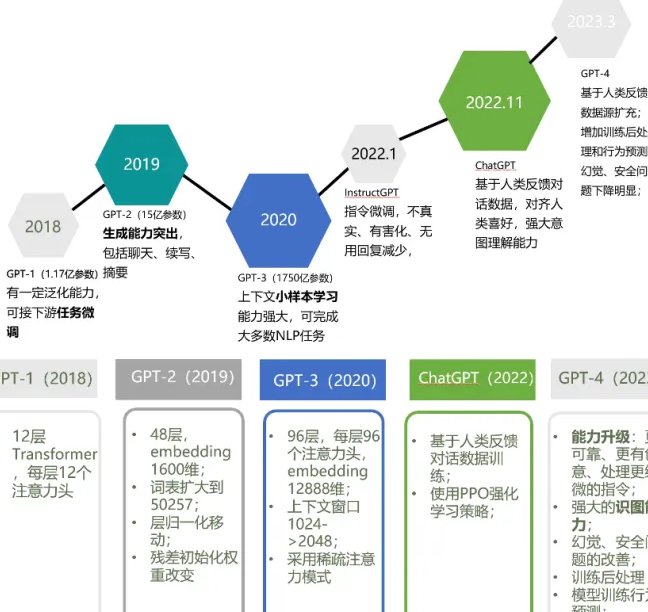

腾讯朱雀实验室一直在更新模型,比如 2025 年推出的 Secbench 测评平台,能提升大模型在网络安全场景的准确性。未来,随着训练数据的丰富,文学作品的检测效果有望改善。

目前 AI 检测缺乏统一规范,不同工具结果差异大。朱雀作为行业标杆之一,其技术路径和实测表现可能影响未来标准的制定。

结语

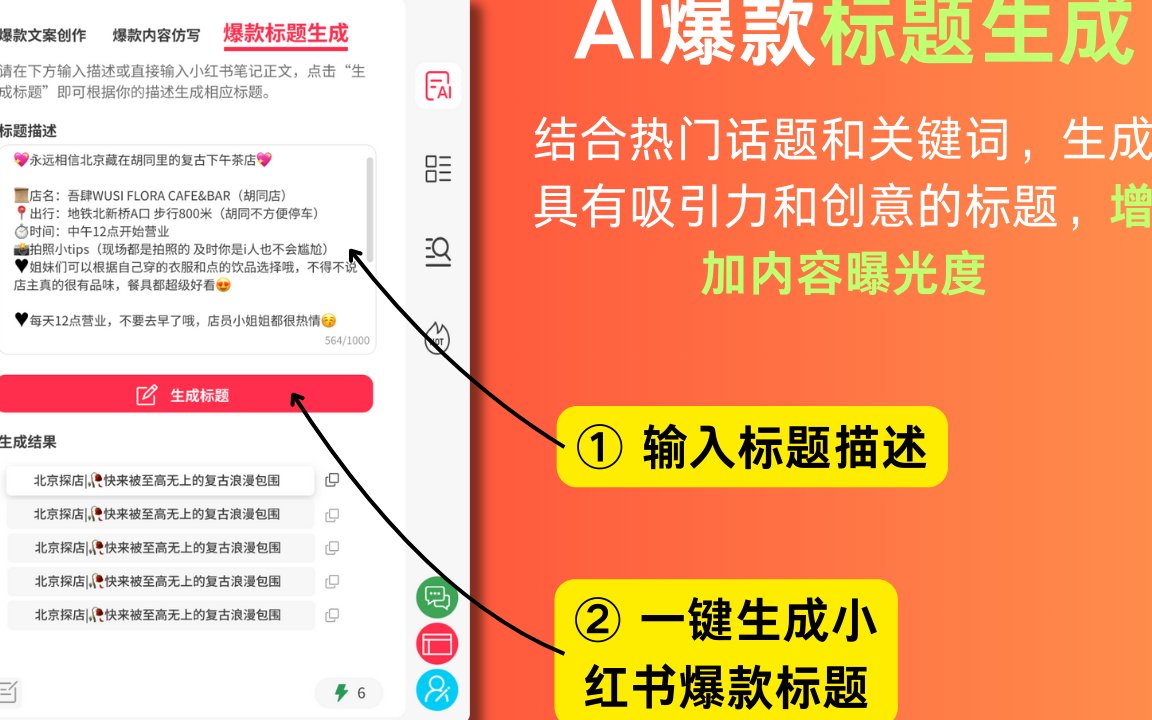

🔗立即免费注册 开始体验工具箱 - 朱雀 AI 味降低到 0%- 降 AI 去 AI 味