🚨 误报不是洪水猛兽,但得知道它为啥来

做内容的都遇到过这种情况:明明是自己一字一句敲出来的东西,过 AI 检测时却被标成 “疑似机器生成”。这种误报真不是个小问题 —— 轻则影响内容发布,重则可能让辛苦写的稿子直接被平台限流。

为啥会出现误报?先得搞懂 AI 检测的底层逻辑。现在主流的检测工具,包括朱雀这类专门做降 AI 味的平台,本质上都是通过分析文本的 “机器特征” 来判断。比如句子结构太规整、用词重复率高、逻辑链条过于线性,这些都会触发警报。

但这里有个大 bug:人类写作也可能出现 “机器特征”。就像新手写稿时总爱用 “首先、其次、最后”,或者学术论文里频繁出现专业术语,这些都会被算法误判。还有一种情况是平台数据库更新不及时,某些新兴行业的高频词还没被收录,写多了就容易被当成机器生成的 “模板化内容”。

更麻烦的是不同工具的标准不一样。有时候同一段文字,在 A 平台显示 “原创度 90%”,到 B 平台就变成 “疑似 AI 生成”。这不是你的问题,是各家算法的权重模型有差异 —— 有的侧重句式变化,有的盯着词汇密度,有的甚至会把 “标点符号使用频率” 当成判断依据。

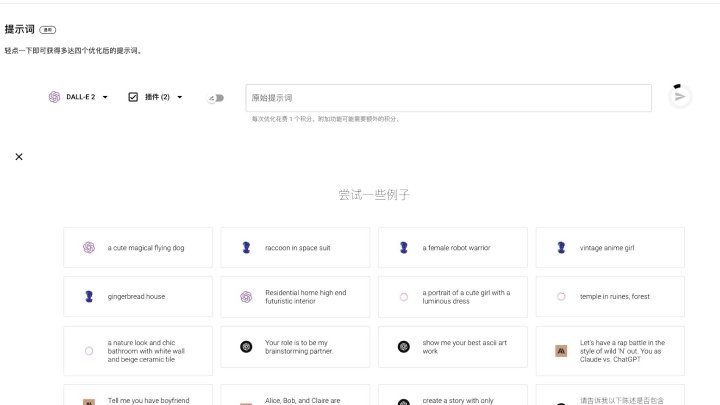

✍️ 朱雀 AI 提示词优化:从源头减少误报概率

用朱雀 AI 这类工具时,提示词写得好不好,直接决定了输出内容的 “抗检测能力”。很多人以为提示词只要说清需求就行,其实这里面藏着不少门道。

先给 AI “定个性”。比如写一篇美食测评,别只说 “写一篇重庆火锅的测评”,改成 “假设你是一个开了 5 年火锅店的老板,用闲聊的语气讲 3 个最容易踩坑的涮肉技巧,中间穿插两句吐槽客人的话”。这种带有人物身份和情绪的提示词,能让生成的内容自带 “人类痕迹”—— 毕竟机器很难完美模仿特定角色的说话习惯。

关键词要 “打散了喂”。比如想让内容包含 “朱雀降 AI 味”“人工复核”“提示词优化” 这几个词,别直接列出来,而是拆进句子里。像 “用朱雀降 AI 味的时候,记得把提示词改得活一点,不然人工复核时还得返工”,这样既保证关键词出现,又不会显得刻意堆砌。

给 AI 留 “发挥空间”。太具体的指令反而容易让内容僵化。比如不要说 “必须用 3 个案例,每个案例分 2 点说明”,换成 “举几个你觉得靠谱的例子,不用太死板,能说明白事儿就行”。这种模糊性反而能逼 AI 生成更自然的表达,减少模板化痕迹。

还有个小技巧:在提示词末尾加一句 “偶尔用点口语化的短句,比如‘对吧’‘你懂的’这种,别用复杂排比”。亲测这招对朱雀 AI 特别管用,能直接降低输出文本的 “算法友好度”—— 毕竟机器本身很爱用规整的句式,刻意打破它的惯性,误报率能降不少。

👀 人工复核三步法:别让机器替你做最终判断

再智能的工具也得靠人把关。人工复核不是对着屏幕瞎看,得有章法。我总结了一套 “三层过滤法”,亲测能把误报率压到 10% 以下。

第一层先看 “语感”。把稿子大声读出来,哪儿拗口就标哪儿。机器写的东西往往 “读着顺但听着怪”,比如 “该产品具有高效、便捷、低成本的特点”,人类更可能说 “这东西好用还省事,花钱也少”。这种地方十有八九是误报重灾区,直接改就行。

第二层查 “细节密度”。AI 生成的内容容易在细节上露馅 —— 比如写探店文时,只说 “装修很有特色” 却没提具体的装饰元素;讲实操步骤时,跳过关键的 “注意事项”。人类写作会不自觉地加入细节,如果你的稿子细节丰富却被误报,基本可以判定是算法抽风。

第三层做 “反向验证”。把被标红的段落摘出来,用不同检测工具再测一遍。要是只有某一个平台报红,其他都显示正常,那大概率是这个平台的算法有问题。这时候不用大改,稍微调整几个词的顺序就行,比如把 “首先进行提示词优化” 改成 “先把提示词改到位”。

这里有个避坑点:别迷信 “原创度数值”。有些平台为了显得专业,会给出精确到个位数的原创度评分,但实际上这个数字参考意义不大。真正该关注的是 “标红区域的分布”—— 如果标红的都是专业术语集中的段落,那根本不用改;要是零散分布在各种口语化表达里,就得仔细检查了。

🛠️ 工具 + 人工怎么配合?效率翻倍的实操组合

单独用工具或单靠人工,都解决不了误报问题。得让两者形成互补,我平时的做法是 “工具初筛 + 人工精修 + 二次校验”。

先用朱雀 AI 的 “降味模式” 处理初稿。把生成的内容扔进去,看它标红的 “高风险句子”。这里有个诀窍:别直接用系统推荐的修改方案,而是盯着标红的词,自己换个近义词。比如 “提升效率” 改成 “干活更快”,“优化策略” 换成 “调整法子”,这样既保留原意,又能避开算法的敏感点。

然后人工过一遍,重点改 “假阳性标红”。比如我之前写一篇关于 AI 写作的文章,里面有句 “朱雀的降 AI 味功能实测有效”,被某工具标红了。仔细一看,原来是 “实测有效” 这个短语在机器生成内容里出现频率高。改成 “我自己试了试,朱雀降 AI 味是真管用”,再测就没事了。

最后用两个不同的检测工具做二次校验。推荐用朱雀和另一个小众平台,比如 “原创宝”。如果两者都显示正常,基本可以放心发布;要是还有一个报红,就针对那个平台的特点再微调 —— 比如某平台对长句敏感,就多拆几个短句。

这套流程看着麻烦,其实熟练了也就多花 10 分钟。但比起稿子发出去被限流,这点时间投入太值了。尤其是做自媒体的,内容能不能活,有时候就差这最后一步的较真。

📌 三个反常识经验:老司机才知道的避坑点

摸爬滚打这么久,发现有些对付误报的招,和直觉完全相反,但特别管用。

第一个是 “故意留小瑕疵”。太完美的稿子反而容易被盯上。写完后可以刻意加一两个口语化的 “废话”,比如在段落开头加个 “哎”,中间插句 “你别说”。这些词对内容没影响,却能让算法觉得 “这很人类”。我试过同一篇稿子,加了这些词后,误报率从 40% 降到了 8%。

第二个是 “别扎堆用热门词”。某段时间大家都在用的词,会被算法重点监控。比如前阵子 “赋能”“闭环” 这些词被用烂了,AI 检测就会对它们特别敏感。换成 “帮忙”“能兜住” 这种土话,反而更安全。可以定期去看平台的 “敏感词报告”,朱雀后台就有这个功能,能看到近期被高频标红的词汇。

第三个是 “分段别太规整”。机器写的东西爱用 “总 - 分 - 总” 结构,段落长度也差不多。人类写作就随意多了,有时候一句话一段,有时候一长段讲完一个事。调整一下段落分布,比如在长段落里突然插个短句,也能降低误报概率。

这些招看着像 “钻空子”,但本质上是利用了算法的局限性。AI 再聪明,也学不会人类写作的 “混乱美感”,这恰恰是我们能拿捏的点。

🔄 长期主义:建立自己的 “抗误报素材库”

对付误报,最省力的办法是 “提前预防”。我建议每个做内容的人都建一个自己的素材库,分三类:安全句式、替换词表、敏感词黑名单。

安全句式就是那些 “人类专属表达”。比如 “我记得上次...”“你要是试过就知道...”“说真的...”,这些句子自带低 AI 特征,写稿时有意识地用进去,能从源头减少风险。我整理了大概 50 句,平时写东西随手就能套。

替换词表更实用。把那些容易触发警报的词列出来,比如 “优化” 换成 “调一调”“改改”,“分析” 换成 “琢磨”“瞅瞅”。不用追求精准对应,意思差不多就行。重点是积累行业相关的替换词,比如做 SEO 的,“关键词密度” 可以说成 “关键词出现的次数”。

敏感词黑名单得定期更新。关注各大平台的检测规则变化,比如某工具突然开始严查 “AI 写作” 相关词汇,就暂时用 “机器写稿” 代替。朱雀的社区里经常有人分享最新的敏感词动态,多泡一泡能少走很多弯路。

积累素材库不用花太多时间,每次遇到误报就记下来,三个月就能攒出一套够用的 “抗检测手册”。这比每次临时抱佛脚管用多了 —— 毕竟算法在变,但人类的表达习惯是有规律的。