朱雀 AI 误报率 20% 高吗?行业标准与识别机制分析

最近有不少创作者反馈,使用朱雀 AI 检测工具时,遇到了 20% 左右的误报率,也就是把人工写的内容误判成 AI 生成。这事儿到底算不算高?咱们得从行业现状、技术原理和实际案例三个方面好好掰扯掰扯。

行业平均水平是多少?朱雀处于什么位置?

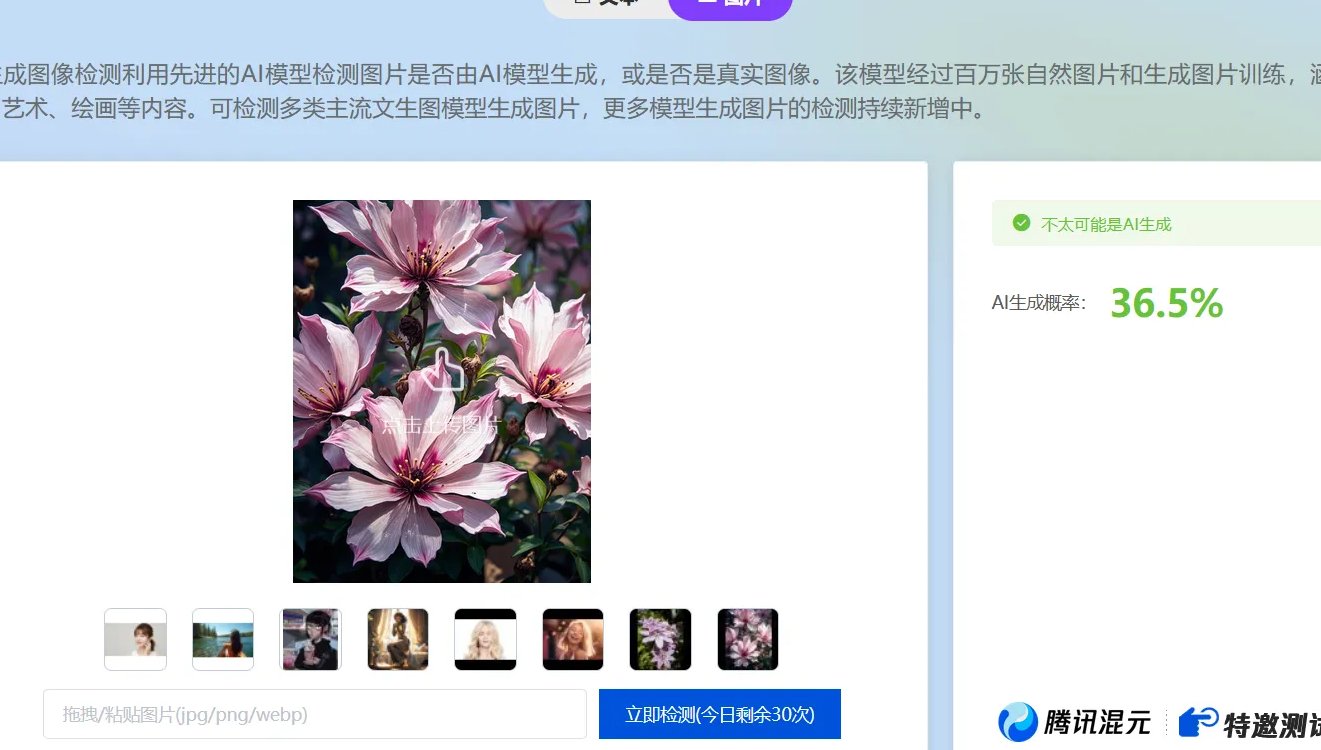

先来看一组实测数据。南方都市报对 10 款主流 AI 检测工具做了测试,发现不同工具的误判情况差异特别大。比如在检测老舍的经典散文《林海》时,朱雀的 AI 检测率是 0%,和知网、维普这些老牌工具表现一样好。可要是换成含 20% AI 内容的假新闻,朱雀的识别率就偏高了,这说明它在不同场景下的表现不太稳定。

从行业整体来看,马里兰大学分析了 12 种检测服务,平均误判率是 6.8%。像 Turnitin 这种教育领域常用的工具,误判率大概 4%,而 OpenAI 早期的检测工具误判率高达 9%。这么一对比,朱雀 20% 的误报率确实超过了平均水平。尤其是在自媒体创作场景中,有用户反映自己手工写的公众号文章被判定为 50% 甚至 68% 的 AI 生成,这说明在某些特定内容类型上,朱雀的误报问题比较突出。

朱雀的识别机制是怎样的?为什么会出现误报?

要搞清楚误报的原因,得先了解朱雀的技术逻辑。它主要通过分析文本的困惑度和爆发性来判断是否为 AI 生成。困惑度就是看句子的流畅度,AI 生成的内容往往逻辑过于完美,用词平滑,困惑度比较低。爆发性则是检测词汇的集中度和句子长度分布,AI 生成的文本可能会出现重复模式或者结构过于工整的情况。

这就导致一些正常的写作习惯容易触发误判。比如使用复杂句式、专业术语或者排比结构,这些在人工写作中很常见,但在朱雀的算法里可能被标记为 AI 特征。还有,像 “深入探讨”“宝贵见解” 这类稍微正式一点的词汇,也可能让检测系统亮起红灯。有个用户分享过,他把自己写的论文放进五个不同的检测工具,结果每个的分数都不一样,这说明不同工具的算法差异很大,朱雀的误判可能和它的模型训练数据有关。

创作者该怎么应对?实用技巧分享

既然知道了误报的原因,咱们就可以针对性地调整写作策略。首先,尽量用口语化表达,别用太正式的书面语。比如把 “因此,AIGC 率的问题确实感到烦恼和困扰” 改成 “AIGC 率的问题让我挺烦的,每次一检测,心都悬着”,这样更自然,也不容易被误判。

其次,避免过度结构化的句子。AI 生成的内容常常有明显的逻辑层次,像 “首先、然后、然而” 这些关联词虽然能让文章更有条理,但在朱雀眼里可能就是危险信号。可以换成 “咱先来说说这个事儿”“还有一点得注意” 这类更随意的过渡。

另外,适当增加一些 “不完美” 的元素。比如故意写错个地名或者时间,或者在段落里加入一两句看似多余的解释。有个用户试过,写完文章先放一放,第二天再用朱雀检测,发现误报率能下降不少。还有人通过调整句式结构,把长句子拆成短句子,用更日常的词汇替换高级词汇,成功把误报率从 45% 降到了 10% 以下。

行业现状如何?未来趋势是怎样的?

目前整个 AI 检测行业还处于快速发展阶段,不同平台的技术成熟度差异很大。25 个主流内容平台里,只有 9 个提供了 AI 声明选项,剩下的要么依赖自有检测技术,要么根本没有标识机制。这就导致很多人工创作的内容因为风格接近 AI 生成,无辜被误判。

不过,技术也在不断进步。朱雀背后的腾讯朱雀实验室一直在优化模型,最近还新增了诗歌体裁检测支持,提升对复杂文本的识别能力。未来,随着多模态检测技术的发展,比如结合图片、视频和文本的综合分析,误报率有望进一步降低。对于创作者来说,现在最重要的是了解工具的特点,主动调整写作习惯,同时关注平台规则的变化。

总的来说,朱雀 AI 20% 的误报率在行业里确实偏高,尤其是在自媒体和创意写作领域。但这并不意味着它完全不可用,只要掌握了正确的应对方法,完全可以把误报率控制在可接受的范围内。随着技术的不断迭代,相信这类问题会逐渐得到解决。创作者们也不用太焦虑,多尝试、多调整,总能找到适合自己的写作风格。

该文章由

diwuai.com第五 ai 创作,第五 AI - 高质量公众号、头条号等自媒体文章创作平台 | 降 AI 味 + AI 检测 + 全网热搜爆文库

🔗立即免费注册 开始体验工具箱 - 朱雀 AI 味降低到 0%- 降 AI 去 AI 味