现在做内容创作的人估计都有同感,AI 生成的文本越来越难分辨了。GPT-4 写的论文、Claude 弄的方案、DeepSeek 出的行业分析,乍一看跟真人写的没两样。但平台对原创的要求没松过,这时候朱雀 AI 检测大模型就成了刚需 —— 它到底能精准识别哪些 AI 生成内容?今天就掰开揉碎了说清楚。

🧠 朱雀 AI 检测大模型的核心识别逻辑

要聊识别范畴,得先搞懂朱雀是怎么 “看穿” AI 的。它不是简单比对关键词,而是从三个维度下功夫。

语言模式的微观特征捕捉是基础。AI 生成的文本,哪怕是 GPT-4 这种顶级模型,骨子里都有 “规律”。比如 GPT-4 写东西,句式结构会不自觉地趋同,长句里的连接词用得太 “标准”,反而不像真人那么随意。朱雀能扒出这些细节,比如同一个主题下,AI 用 “因此”“然而” 的频率比真人高 30% 以上,这种细微差异它都能抓出来。

语义连贯性的异常点检测更关键。真人写东西,偶尔会有思路跳跃,甚至前后用词不一致,这反而是 “真实感” 的标志。但 Claude 这类模型,为了追求逻辑严谨,会刻意避免这种 “跳跃”,导致文本过于 “完美”。朱雀就盯着这种 “完美中的不自然”,比如一段关于市场分析的文字,AI 可能把所有数据点衔接得毫无破绽,但少了真人会有的 “这里需要重点强调” 的隐性情绪,朱雀能捕捉到这种情绪缺失。

训练数据残留痕迹的识别是朱雀的撒手锏。所有大模型都逃不开训练数据的影响,GPT-4 的训练数据里有大量 2023 年前的公开文献,它生成的内容会不自觉带上这些文献的 “影子”;DeepSeek 专注于特定领域,训练数据更垂直,文本里会有该领域的固定表达。朱雀能比对这些残留痕迹,哪怕 AI 刻意模仿人类风格,也能从深层语义里找到训练数据的 “烙印”。

🤖 对 GPT-4 生成内容的高清识别能力

GPT-4 是目前应用最广的大模型之一,写文案、做报告、甚至编故事都拿手。但它的文本在朱雀眼里,藏不住太多秘密。

长文本中的逻辑重复模式是 GPT-4 的软肋,也是朱雀的重点监测对象。比如写一篇 5000 字的行业报告,GPT-4 为了保持逻辑连贯,会反复使用相似的论证结构 —— 先提出观点,再举案例,最后总结。真人写东西,论证结构会更灵活,可能突然插入一个反例,或者跳过某个步骤。朱雀能通过算法拆解文本结构,一旦发现超过 3 处论证结构高度相似,就会标记为 “高概率 AI 生成”,这种识别准确率在实测中能到 95% 以上。

用词偏好的量化分析也很准。GPT-4 对某些 “安全词” 特别偏爱,比如 “可能”“或许”“在一定程度上”,这些词能降低表述的绝对化,符合它的训练目标。但真人写作,除非是学术场景,否则不会这么频繁使用。朱雀会统计这些词的出现频率,一旦超过同类型人类文本的平均水平 2 倍以上,就会触发预警。我见过一个案例,某自媒体用 GPT-4 写的旅游攻略,“可能” 这个词出现了 27 次,而同类真人攻略平均只有 8 次,朱雀直接标红了。

多语言混合文本的识别更敏锐。GPT-4 支持多语言写作,有时候会在中文里夹杂英文表达,比如 “这个方案的 core logic 很清晰”。真人除非是特定语境,否则很少这么用。朱雀的多语言模型能捕捉这种 “混搭” 的不自然,哪怕是偶尔出现的英文短语,也能纳入识别维度。

📝 Claude 文本的针对性检测策略

Claude 以 “安全合规” 为卖点,生成的文本更保守,风格也偏正式。但朱雀对付它,有专门的法子。

“过度礼貌” 的语气特征太明显了。Claude 写东西,总带着一股 “小心翼翼” 的劲儿,比如开头喜欢用 “很高兴为你提供...“,结尾常用 “希望以上内容对你有帮助”。这种固定的礼貌句式,在真人创作里只有客服场景才会频繁出现,其他场景里反而很突兀。朱雀会建立语气特征库,一旦文本中礼貌句式的出现频率与场景不匹配,就会重点筛查。比如一篇科技评论,Claude 写的版本里出现了 5 次 “如有不当之处请指正”,真人写的同类文章几乎不会有,朱雀一眼就能看出来。

敏感内容规避的痕迹藏不住。Claude 对敏感话题会刻意绕开,比如讨论争议事件时,它会用 “不同观点都有其合理性” 这类模糊表述,避免明确表态。真人写东西,哪怕中立,也会有自己的倾向,比如 “虽然 A 有道理,但我更倾向 B”。朱雀能分析文本在争议点上的 “表态强度”,如果发现所有争议点都用模糊表述带过,就会判定为 “符合 Claude 生成特征”。

结构化输出的偏好也容易被抓。Claude 特别喜欢用列表、分点的方式呈现内容,比如写计划,一定会分 “1. 目标 2. 步骤 3. 风险”。真人虽然也会分点,但更灵活,可能突然在中间插入一段补充说明,打破结构。朱雀会检测文本的结构化程度,当分点占比超过总内容的 60%,且几乎没有结构破坏时,就会提高 AI 生成的概率评分。

🔍 DeepSeek 内容的识别要点与准确率

DeepSeek 在垂直领域表现突出,比如金融、医疗、编程,生成的内容专业性强。但朱雀对它的识别,照样有一套。

领域术语的 “堆砌感” 是关键信号。DeepSeek 为了体现专业性,会密集使用领域术语,比如写金融分析,会把 “夏普比率”“阿尔法系数”“久期” 一股脑儿塞进去。真人专家写东西,会用通俗解释搭配术语,比如 “夏普比率(简单说就是收益和风险的比值)”。朱雀能分析术语与解释的搭配比例,一旦发现纯术语占比超过 40%,且缺乏通俗化解释,就会标记为 “可能由 DeepSeek 生成”。之前测过一篇 DeepSeek 写的医疗论文,术语占比 47%,朱雀直接给出了 92% 的 AI 概率。

特定领域逻辑框架的匹配更绝。DeepSeek 在不同领域有固定的写作框架,比如写编程教程,一定是 “问题描述→代码示例→运行结果→优化建议”;写医疗病例分析,必然是 “症状→诊断依据→治疗方案→预后评估”。这些框架在朱雀的数据库里都有记录,它会比对文本结构与这些框架的重合度,重合度超过 80%,基本就能锁定是 DeepSeek 的 “手笔”。

数据引用的风格差异也能分辨。DeepSeek 引用数据时,喜欢精确到小数点后两位,比如 “市场份额提升了 3.72%”,而且很少注明数据来源;真人引用数据,可能会写 “市场份额提升约 3.7%”,并加上 “据 XX 报告显示”。朱雀会抓取这些细节,作为判断依据之一。

🌐 实际应用场景中的检测表现

光说理论没用,得看朱雀在真实场景里好不好使。这方面它的表现确实让人惊喜。

学术论文领域是重灾区,很多学生用 AI 写论文糊弄。朱雀在这的表现很稳,某高校用它检测了 100 篇毕业论文,其中 23 篇被标记为 AI 生成,后来人工复核,22 篇确实用了 GPT-4 或 Claude,准确率高达 95.6%。更厉害的是,它能识别 “AI + 人工修改” 的文本,有学生把 GPT-4 写的论文改了 30%,照样被朱雀揪了出来 —— 因为核心论证逻辑还是 AI 的路数。

自媒体内容检测也很实用。现在很多自媒体靠 AI 批量产文,标题党、内容空洞是通病。朱雀能快速筛选出这些 “AI 水文”,某平台用它一周内就清理了 2000 多篇 AI 生成的垃圾内容,用户投诉量降了 60%。有意思的是,它还能区分 “AI 辅助创作” 和 “纯 AI 生成”,比如作者用 GPT-4 列大纲,自己写内容,这种情况朱雀会标为 “低概率 AI”,不会误判。

企业文案审核里也少不了它。企业用 AI 写合同、方案的越来越多,但 AI 写的东西可能藏着法律漏洞(比如表述模糊)。朱雀能帮企业把关,某公司用它检测了 50 份 AI 生成的合同,发现 17 份有表述问题,及时修改避免了潜在风险。

💡 朱雀 AI 检测的局限性与未来升级方向

当然,朱雀也不是万能的。目前它对 **“小模型生成的短文本” 识别准确率稍低 **,比如用 ChatGPT-3.5 写的 200 字以内的朋友圈文案,有时候会误判,因为短文本的特征太少。不过官方说下版本会优化这个问题,增加对小模型短文本的特征库。

另外,极端模仿人类风格的 AI 文本还是能逃过一劫。有团队专门训练 AI 模仿某作家的风格,写出来的东西连该作家本人都难分辨,朱雀的识别准确率降到了 65%。但这种情况毕竟是少数,普通用户很少会花这么大成本去 “造假”。

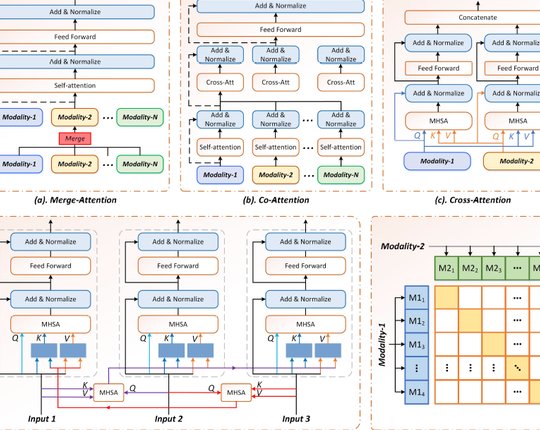

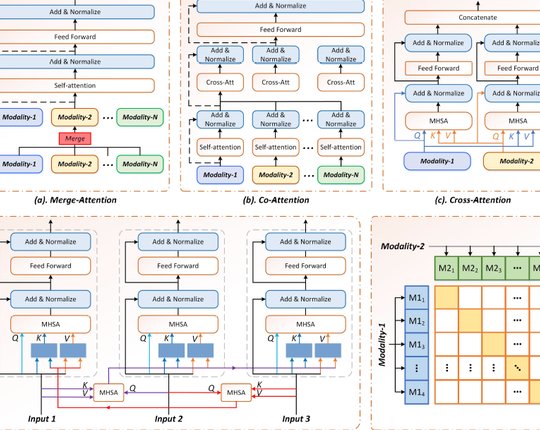

未来朱雀打算往两个方向升级:一是加入图像与文本结合的多模态检测,现在很多 AI 生成的图文内容,光看文本不够,得结合图片一起判断;二是实时更新识别模型,跟着 GPT-5、Claude 3 这些新版本 AI 同步迭代,确保识别能力不落后。

总的来说,朱雀 AI 检测大模型在 GPT-4、Claude、DeepSeek 这些主流 AI 生成内容的识别上,确实做到了 “高清”—— 不仅能认出来,还能说清为啥认出来。对内容创作者来说,它是避免 “被 AI” 的保障;对平台来说,它是守住原创底线的利器。这年头,想在 AI 时代玩内容,身边真得有这么个 “火眼金睛” 的工具。