🔍 免费 AI 润色会泄露数据吗?安全使用指南大公开

🚫 免费 AI 润色的常见风险

- 数据被用于模型训练

像 DeepSeek 这类工具,在用户协议里就明确写着,用户输入的内容可能会被用于训练其他模型。你想想,要是你上传的是未发表的学术论文,里面的实验方法、数据结果被系统记录下来,万一被别人提前 “借鉴” 了,那可就亏大了。

- 隐私政策暗藏陷阱

有些工具的隐私政策写得云山雾罩,你可能没注意到里面有一条:“我们有权将用户数据共享给第三方合作伙伴”。这就相当于你把数据拱手送给了别人。之前有个政府部门的小张,就是因为没仔细看隐私政策,用 DeepSeek 润色包含经济敏感数据的报告,结果数据出现在了境外智库的分析报告里。

- 镜像网站风险重重

国内很多号称能直接使用 ChatGPT 的网站,其实都是镜像网站。这些网站的创建成本极低,很可能会把你的信息转卖或者泄露。而且你根本不知道这些网站背后是谁在运营,数据安全完全没保障。

🔒 安全使用 AI 润色的五大原则

- 选择可靠的工具

优先选择有明确隐私政策、口碑好的工具。比如爱改写官网,它采用 SSL 安全加密,能有效保护数据传输安全。如果是学术写作,像 LetPub 这类专门做学术润色的平台更靠谱,它们会签署保密协议,内容安全可控。

- 仔细阅读隐私政策

别一看到 “同意” 就点,花几分钟看看隐私政策里的关键条款。比如数据会保存多久?会不会被共享给第三方?有没有匿名化处理措施?要是发现有不合理的地方,果断换工具。

- 避免上传敏感信息

这是最基本的原则。不管用什么工具,涉及个人隐私、商业机密、未发表的研究成果等敏感内容,都不要上传。如果必须润色这类内容,最好选择本地运行的工具,比如 Sidekick,它完全离线使用,所有数据都留在本地。

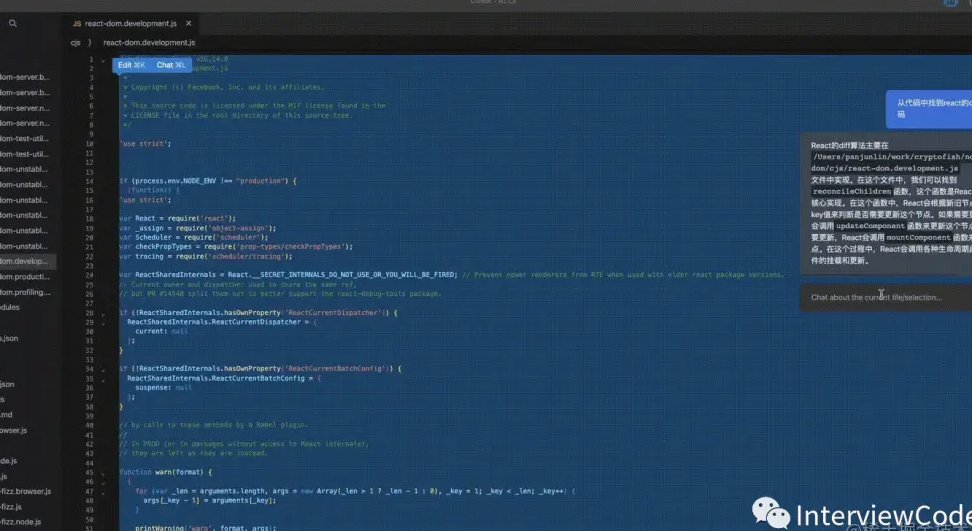

- 使用本地处理工具

本地工具的好处就是数据不出门。像 “AI 润色工具” 这款软件,支持本地离线运行,无需联网就能完成润色,还能智能重组句式、替换词汇,既保证了安全,又提升了效率。

- 定期检查和清理记录

用完工具后,别忘了清理历史对话记录和缓存文件。有些工具会默认保存你的输入内容,时间长了就成了安全隐患。另外,定期更改账户密码,开启二次验证,也能增加账户的安全性。

🛠️ 安全工具推荐

- 本地润色工具

- Sidekick:基于开源模型构建,支持从本地文件、文件夹提取信息,完全离线运行,适合处理敏感内容。

- AI 润色工具:操作简单,能快速完成大段文本的润色,支持多种格式输入,本地运行无风险。

- 云端安全工具

- 爱改写:采用 SSL 加密,内置 AI 特征消除引擎,能有效降低 AI 生成痕迹,同时保证内容安全。

- LetPub:专注学术润色,使用专有学术模型,不上传、不训练、不共享用户数据,还提供人工审阅服务。

- 安全认证验证

选择有安全认证的工具更放心。比如通过 LLM - Shield 认证的工具,分为 L1 到 L5 级,L3 级相当于银行级数据防护,用户可以在认证查询平台输入产品编号进行验证。

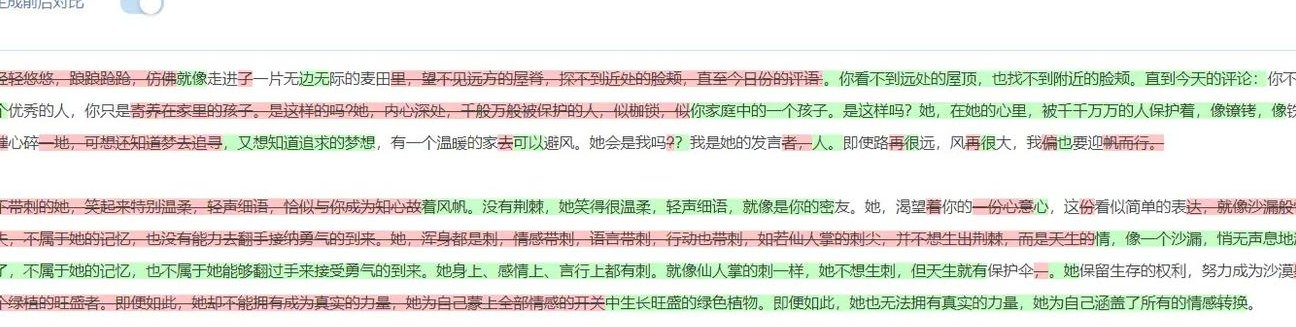

📝 如何降低 AI 生成痕迹

- 多轮修订机制:先让 AI 生成初稿,然后自己进行人工修改,调整句式、替换词汇,反复打磨。

- 使用专业术语:在学术写作中,适当使用专业术语,能让内容更具权威性,也能降低 AI 痕迹。

- 调整语言风格:根据不同的场景选择合适的语气,比如正式、活泼、简洁等,让内容更自然。

- 检查和优化逻辑:通读内容,确保逻辑连贯,过渡自然,避免出现生硬的转折。

💡 总结

🔗立即免费注册 开始体验工具箱 - 朱雀 AI 味降低到 0% - 降 AI 去 AI 味