很多人在使用 Kimi 时,总觉得生成的内容要么不够精准,要么需要反复修改,这其实和指令的质量直接相关。一个好的提示词就像给 Kimi 的 “导航地图”,能让它快速找到你想要的方向。专家建议,结构化提示词是降低成本的关键第一步。比如,在撰写外卖好评时,初始提示词可能包含冗余信息,像 “确保获得商家好评返现” 这类超出 Kimi 控制范围的要求,反而会干扰模型的判断。正确的做法是,先明确核心目标,再逐步细化约束条件。例如,将目标简化为 “生成符合小红书种草风格的 30-50 字好评文案”,同时加入具体的例子,如 “黄焖鸡米饭:老板人太实在了,给的份量非常足,鸡肉很香,汁也可以拿来拌饭,性价比超高”,这样 Kimi 就能更精准地模仿目标风格。

复杂任务往往需要消耗更多资源,这时候把大任务拆分成子任务就显得尤为重要。比如,撰写一篇万字行业报告时,直接让 Kimi 生成可能会导致内容松散或偏离主题。专家建议,先让 Kimi 生成大纲,再分别细化每个章节。例如,先输入 “生成 2023 年人工智能行业发展报告大纲”,得到框架后,再针对 “技术突破”“市场规模”“挑战与趋势” 等模块逐一细化。这样不仅能减少重复生成的成本,还能让内容更具逻辑性。

Kimi 提供了多种模型版本和参数选项,合理调整这些设置能显著降低成本。专家指出,对于简单的文本生成任务,选择基础版模型即可,而复杂的推理或多模态任务则需要调用专业版。例如,Kimi K2 的输入成本为每百万 tokens/4 元,输出为 16 元,相比 Claude Sonnet 4 的 3 美元 / 百万 tokens,成本降低了 80%。此外,调整温度(temperature)和 top_p 参数也能控制生成质量和速度。温度越高,生成内容越随机;温度越低,内容越保守。对于需要稳定输出的场景,如合同条款分析,将温度设为 0.5 左右,既能保证准确性,又能减少重复生成的次数。

Kimi 的 “Context Caching” 功能是降低成本的一大利器。该功能允许用户预先存储常用的上下文信息,当再次请求类似内容时,直接从缓存中调用,无需重新计算。例如,在频繁查询上市公司财报时,先创建一个包含公司基本信息和历史数据的缓存,后续查询时只需输入新的时间范围,Kimi 就能快速生成对比分析报告,成本可降低 90%,响应速度提升 83%。不过,专家提醒,缓存的有效期和存储成本需要合理规划,避免因过期数据导致的结果偏差。

💡 行业实战:不同场景下的指令优化技巧

- 学术写作:输入 “对比近五年 NLP 领域突破性论文,生成研究综述框架”,Kimi 会自动提取核心观点并梳理研究趋势,比手动整理文献节省 70% 的时间。

- 法律分析:使用 “提取关键证据时间线,匹配刑法第 XX 条适用性分析” 指令,Kimi 能快速梳理案件资料并生成带法律依据的案情摘要,降低人工分析的成本。

- 编程开发:粘贴报错信息并输入 “@编程助手,修复这段 Python 代码的逻辑错误”,Kimi 会直接给出修改建议,甚至关联 GitHub 仓库自动添加注释,提升开发效率。

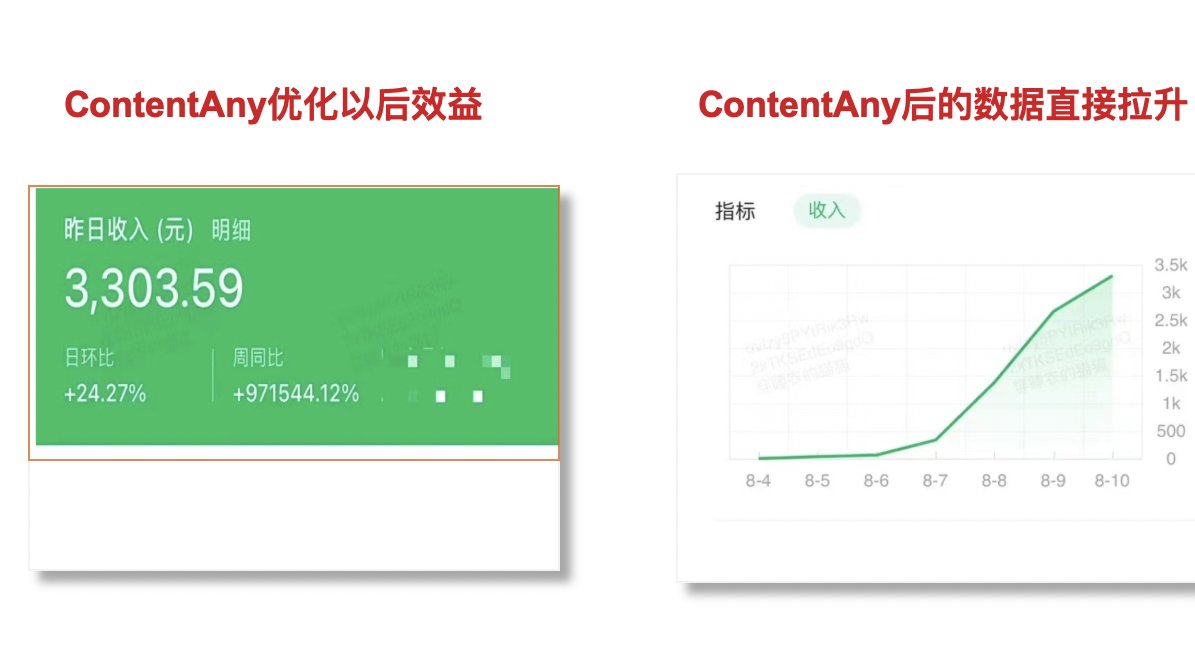

在同等性能下,Kimi 的成本优势非常明显。例如,生成 1000 字的营销文案,Kimi 的成本约为 0.2 元,而 GPT-4O 的成本高达 1.5 元。对于企业用户,Kimi 的批量处理功能更具吸引力。某汽车厂商通过输入 “智能驾驶技术” 关键词,Kimi 自动整合 3000 + 小时测试素材生成宣传视频,效率提升 8 倍,成本降低 90%。此外,Kimi 的开源模型 Kimi-K2-Instruct 支持自定义训练,进一步降低了企业的技术投入门槛。

降低 AIGC 成本的关键在于优化指令质量、合理拆分任务、灵活调整模型参数,并充分利用 Kimi 的缓存和多模态功能。专家强调,每次生成后都要分析资源消耗情况,比如查看 token 使用量和响应时间,逐步优化指令和流程。通过这些方法,不仅能提升内容质量,还能让 Kimi 的使用成本降低 50% 以上。

🔗立即免费注册 开始体验工具箱 - 朱雀 AI 味降低到 0%- 降 AI 去 AI 味