🚀 朱雀大模型误判问题 2025 解答:文本识别原理全解析

🧠 朱雀大模型的文本识别逻辑

😵 误判的三大 “元凶”

- 数据偏差

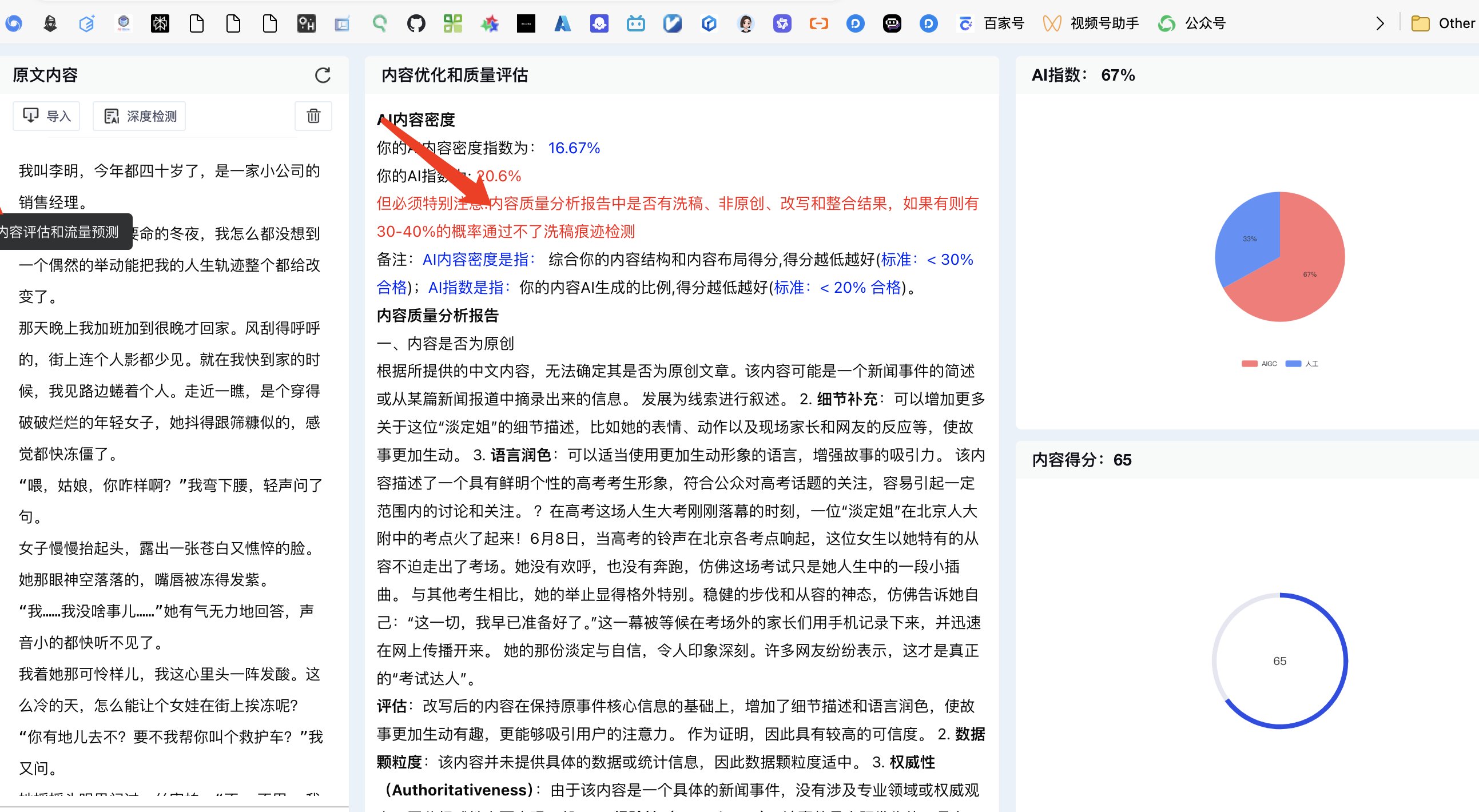

训练数据里如果某类风格的文本占比过高,模型就容易形成刻板印象。比如测试中发现,老舍的《林海》被茅茅虫检测为 99.9% AI 生成,但朱雀、知网等工具却能准确识别。这可能是因为某些检测工具的训练数据里,类似风格的文本被错误标注为 AI 生成,导致模型 “学歪了”。还有一些专业领域的文章,像学术论文,因为用词严谨、逻辑强,也容易被误判。

- 算法局限性

朱雀大模型主要通过对比文本与大模型的预测内容来推测 AI 生成概率。但这种方法有个问题,就是对 “非典型” 人类写作不敏感。比如方文山的推荐语,用了 “紫光密码”“叙事光纤” 这类带有科幻色彩的词汇,模型就可能把它当成 AI 生成的 “创新表达”。还有一些经过深度润色的文章,通过调整句式、加入口语化表达,虽然本质还是 AI 生成,但模型可能就检测不出来了。

- 上下文理解不足

模型在处理复杂语义时,容易忽略上下文的关联性。就像苹果研究员提到的数学题,加上一句 “其中 5 个比平均小”,部分大模型就会错误地减掉这五个,因为它没理解到 “大小不影响数量计算” 这个逻辑。在文本检测中也是一样,像 “祈祷机器” 这种在科幻小说里常见的意象,模型可能就会当成 AI 编造的词汇。

🛠️ 如何降低误判风险

- 内容优化技巧

- 增加口语化表达:适当加入 “你猜怎么着”“说实话” 这类口头禅,让文本更有 “人味”。

- 调整句式结构:故意写几个语法上有点小瑕疵的句子,比如把长句拆成短句,或者用破折号、感叹号制造语气变化。

- 融入个人化内容:加入一些只有人类才会有的细节,比如 “记得去年在海边散步时,我突然想到了这个点子”。

- 检测策略调整

- 分块检测:把文章分成几个部分分别检测,避免因为某一段的 “AI 特征” 影响整体结果。比如方文山的推荐语,删掉标题和名字后检测结果大不相同,说明这些元素可能被模型特别关注。

- 多工具对比:不要只依赖朱雀,还可以用知网、PaperPass 等工具交叉验证。比如测试中发现,朱雀对《林海》的检测结果准确,但万方却误判了 35.6% 的内容。

- 人工二次审核:检测完后自己通读一遍,看看有没有逻辑生硬、用词重复的地方,手动修改一下。

- 关注模型更新

朱雀团队一直在优化模型,2025 年新增了动态进化机制,每天更新 10 万条生成样本训练数据,还拓展了对诗歌等体裁的检测支持。大家可以定期关注官方公告,了解最新的检测规则变化。比如之前对 “困惑度” 的计算方式调整后,一些文学性较强的文本误判率就有所下降。

📊 行业对比与未来展望

🔗立即免费注册 开始体验工具箱 - 朱雀 AI 味降低到 0%- 降 AI 去 AI 味