最近一直在关注高校对论文 AI 使用的规范更新,说真的,这波操作对咱们公众号运营太有参考价值了。你想啊,都是内容创作领域,高校踩过的坑、划的红线,完全能帮咱们避开公众号运营里的合规雷区。

📝 从高校 AI 论文 “标注要求” 看公众号:透明是合规第一步

现在几乎所有高校都明确要求,论文里如果用了 AI 工具(不管是 ChatGPT 还是国产的 AI 写作工具),必须在文末或致谢里明确标注 AI 参与的环节—— 比如 “摘要由 AI 辅助生成,经人工修改”“文献综述部分使用 AI 整理初步框架”。这事儿看着小,其实藏着合规的底层逻辑:让内容使用者知道 “哪些是人工原创,哪些是 AI 参与”。

这对公众号运营来说简直是现成的模板。你想啊,现在很多公众号小编图省事,直接用 AI 生成整篇推文,甚至连案例、数据都让 AI 编。用户读的时候可能没感觉,但一旦出问题 —— 比如 AI 编了假数据、抄了别家观点 —— 读者追责、平台处罚跑不了。但如果咱们像高校论文那样,在文末加一句 “本文部分段落由 AI 辅助生成,核心观点及案例均经人工核实”,不仅能减少用户被误导的风险,平台也会觉得你在主动规避合规问题。

更重要的是,透明标注还能积累用户信任。我见过一个科技类公众号,专门在每篇推文末尾加个 “AI 使用说明”,比如 “本文产品评测框架由 AI 生成,实际体验及数据为小编实测”,反而有人在评论区说 “这号真实在”。你看,合规和用户好感完全能双赢。

🔍 高校论文 “AI 查重” 新规,戳中公众号 “原创焦虑” 的痛点

高校现在对 AI 生成内容的查重越来越严了 —— 不只是查文字重复率,还专门用 AI 文本检测工具(比如 GPTZero、Turnitin 的 AI 检测功能)查 “AI 生成占比”。有的学校甚至规定,AI 生成内容超过 30% 直接打回重写,超过 50% 按学术不端处理。这背后的逻辑很简单:AI 可以用,但不能替代人工原创。

这事儿对公众号运营简直是 “精准预警”。现在公众号平台对 “AI 生成内容” 的识别也越来越厉害,之前就有号主反馈,连续发了 3 篇 AI 生成的推文,直接被限制流量,理由是 “非原创内容占比过高”。你可能会说 “我用 AI 生成后改几个词不就行了?” 别傻了,平台的 AI 检测工具比咱们想的灵 —— 它不光看文字,还看逻辑连贯性、观点独特性。就像高校论文里,AI 生成的段落往往逻辑生硬、观点空泛,公众号推文里的 AI 痕迹也是同理,用户一眼能看出 “没灵魂”,平台更能识别 “没原创”。

那该怎么办?参考高校的做法:把 AI 当 “辅助工具”,而不是 “代笔”。比如用 AI 列提纲,但观点得自己提炼;用 AI 找案例,但得自己核实真实性;用 AI 润色语句,但核心论据得自己攒。就像写论文时 AI 能帮你整理文献,但论点必须是自己的研究成果一样,公众号运营里,AI 可以处理 “技术活”,但 “原创的魂” 得握在自己手里。

🚫 高校对 “AI 滥用” 的处罚,藏着公众号运营的 “绝对红线”

最近看到好几所高校的通报:有学生用 AI 生成整篇论文提交,被记过处分;有学生让 AI 编造实验数据,直接取消学位申请资格。这些处罚看着狠,但本质是在划红线:AI 不能用来造假、不能替代核心创作、不能规避学术规范。

这几条红线,公众号运营一条都碰不得。先说 “造假”—— 有的公众号为了博流量,让 AI 生成 “某明星疑似离婚”“某产品致癌” 之类的假新闻,甚至用 AI 编 “用户好评”。之前就有个母婴号,用 AI 生成 “某奶粉导致婴儿过敏” 的虚假案例,被品牌方起诉,还被平台永久封号。这和高校里用 AI 编实验数据有啥区别?都是用 AI 造假,后果必然严重。

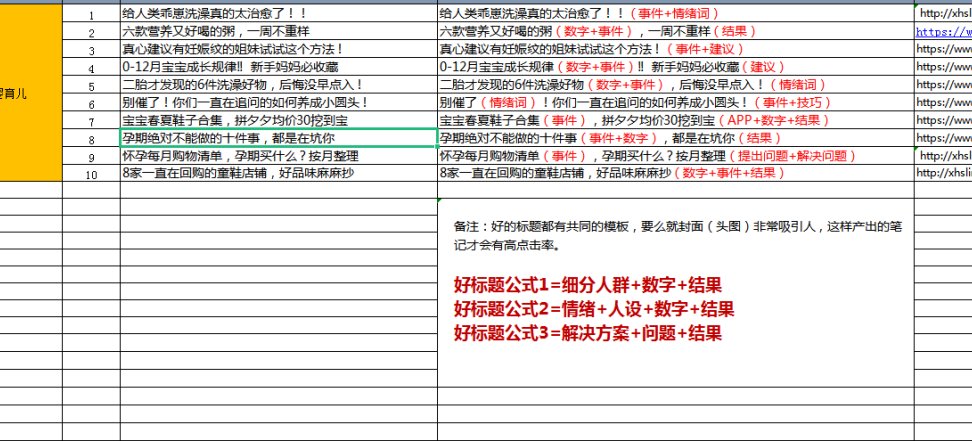

再说说 “替代核心创作”。高校不允许 AI 写整篇论文,是因为论文的核心是 “学术思考”;公众号运营也一样,核心是 “对用户有价值的观点和信息”。如果你的公众号天天发 AI 生成的 “万能模板文”—— 比如 “10 个养生小技巧”“5 个赚钱方法”,内容空洞、观点抄袭,就算暂时没被处罚,用户也会慢慢取关。就像学生总用 AI 写论文会被老师盯上,公众号总发 AI 垃圾文,也一定会被平台列入 “低质内容池”。

🎯 高校 “人工复核” 要求,给公众号运营的 “安全保险”

现在高校不光要求标注 AI 使用,还明确规定:AI 生成的内容必须经过人工逐句复核。比如有学校要求,用 AI 写的段落,要在旁边标注 “已核对事实”“已调整逻辑”,导师还要抽查复核记录。这招特别实在 ——AI 再智能,也可能犯低级错误,人工复核就是最后一道防线。

公众号运营里,这步简直是 “保命操作”。我见过一个财经号小编,用 AI 生成 “2024 年基金推荐”,AI 把某只已清盘的基金写进去了,小编没核对就发了,结果被读者投诉 “误导投资”,平台直接扣了信用分。如果他像高校论文那样,对 AI 生成的每只基金都去基金公司官网核对最新状态,根本不会出这问题。

其实人工复核不用太复杂,就抓三个点:一是事实性内容(数据、案例、时间、人名)必须查原始来源;二是观点逻辑,看看 AI 写的论证是不是通顺,有没有前后矛盾;三是合规性,比如有没有敏感词、有没有侵犯别人版权。花 10 分钟做这三步,比发出去后被投诉、处罚省太多事。

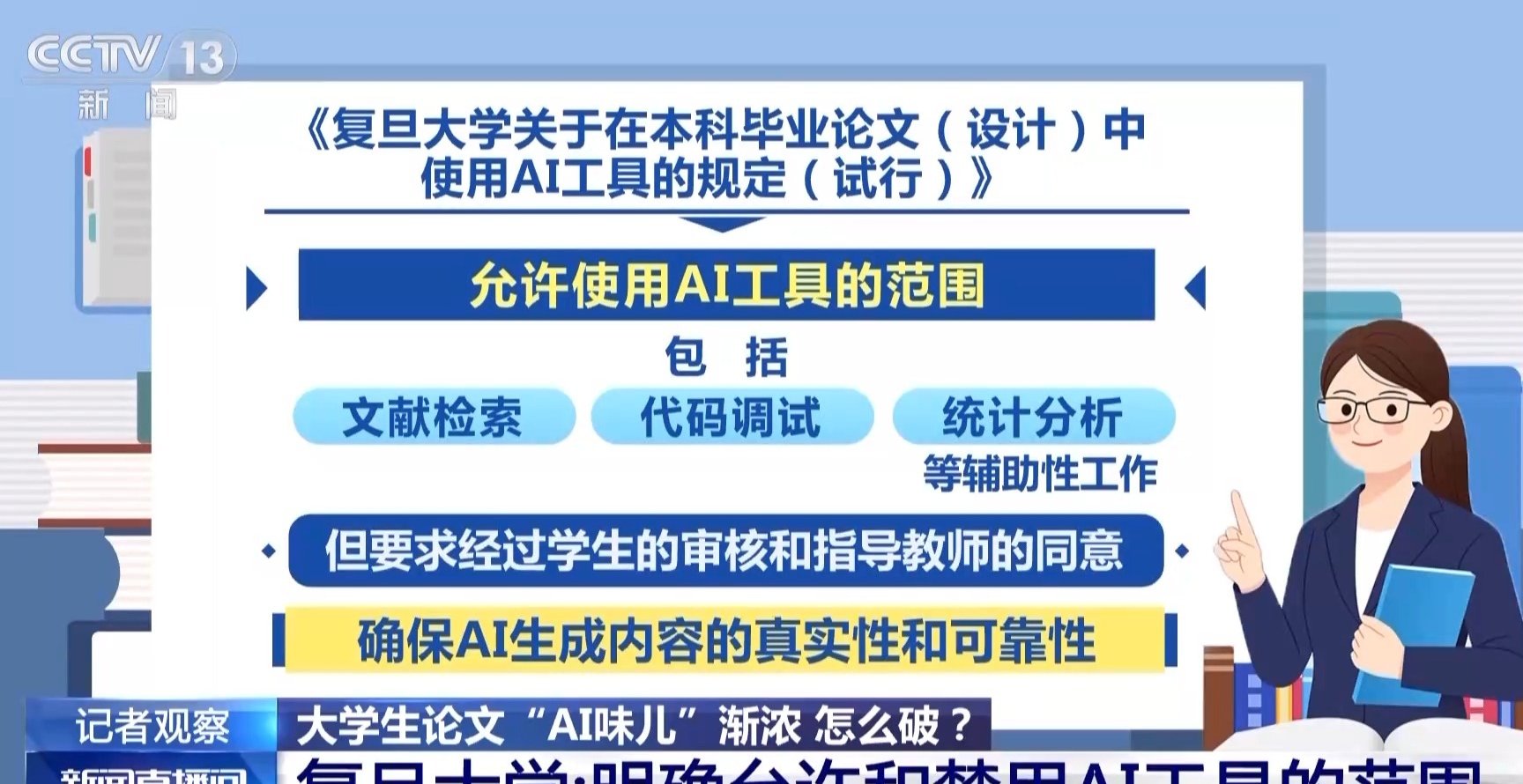

💡 从高校 “AI 工具限定” 看公众号:选对工具能少走弯路

有意思的是,有些高校开始 “指定 AI 工具清单”—— 比如只允许用经过备案的学术 AI 工具,禁止用匿名的、数据来源不明的 AI。理由很简单:正规工具的生成内容更可控,出了问题能追溯。

这对公众号运营选 AI 工具来说,简直是直接指路。现在市面上 AI 写作工具太多了,但很多工具的数据来源不透明,生成的内容可能藏着抄袭片段,甚至有敏感信息。咱们选工具时,就得学高校:优先用有明确资质、能提供 “内容溯源” 的工具。比如有的 AI 工具会标注 “本段参考自 XX 公开报道”,有的能生成 “原创度报告”,这些功能虽然麻烦点,但能帮咱们避开 “不知情抄袭” 的坑。

另外,别迷信 “全功能 AI”。高校用 AI 写论文,会分开用 —— 查文献用专门的学术 AI,润色用语法 AI,咱们公众号运营也一样:写提纲用思维导图 AI,查热点用舆情 AI,润色用文案 AI,分开用不仅效率高,还能减少单一 AI 带来的 “内容同质化” 问题。

其实不管是高校论文还是公众号运营,AI 都只是工具。高校划的那些规范,本质不是禁止用 AI,而是让 AI“服务于人,而不是替代人”。对咱们公众号运营来说,照着高校的合规逻辑走 —— 透明标注、人工原创为主、严格复核、选正规工具 —— 既能避开平台处罚,又能做出让用户认可的内容。你说,这波 “抄作业” 是不是稳赚不亏?