🛠️ 技术原理大比拼:AI 查重工具如何识别 AIGC 内容

🔍 主流工具实测对比:谁是真正的 “AI 猎手”

1. 学术领域:Turnitin vs 知网

- Turnitin:在检测纯 AI 生成内容时表现优异,但对混合内容(如人类撰写 + AI 润色)容易误判。华盛顿时报测试发现,其对经济学论文的误判率高达 8%,原因是这类文本的固定写作风格与 AI 生成特征相似。此外,它无法识别经 Quillbot 改写的内容。

- 知网:对真实文章的误判率较低,在检测老舍《林海》时 AI 率趋近于 0,但对 AI 生成的假新闻(含 20% AI 内容)识别率偏低,仅为 10% 左右。其优势在于学术数据库庞大,但对非学术类内容的检测能力较弱。

2. 综合检测:朱雀大模型检测 vs 茅茅虫

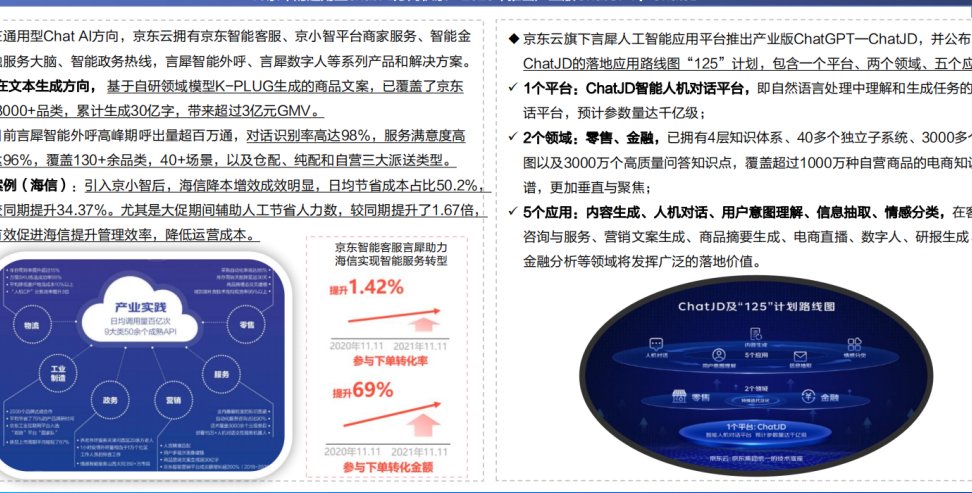

- 朱雀大模型检测:在南都测评中综合表现最佳,对 100% AI 生成内容的识别率达 100%,对真实文章的误判率几乎为 0。其核心优势是双链路检测:既通过语言模式分析,又通过语义逻辑判断,有效降低了漏检率。

- 茅茅虫:误判率最高,对老舍《林海》的 AI 检测率竟达 99.9%,对人工撰写的学科论文误判率也超过 90%。其算法可能过度依赖句式模板匹配,导致对传统文学作品和专业论文的识别严重失真。

3. 图片检测:朱雀 vs 挖错网

🚧 误判难题:AI 查重工具的 “阿喀琉斯之踵”

- 学术论文:数学公式、法律法规引用等高度规范的表达,常被误判为 AI 生成。例如,某数学系学生的论文因大量公式出现 30% 以上 AI 率。

- 经典文学作品:朱自清《荷塘月色》被某工具检测出 62.88% 的 AI 率,刘慈欣《流浪地球》片段 AI 率也达 52.88%。这是因为这些文本的语言规范性和逻辑连贯性接近 AI 生成特征。

- 混合创作:部分学生采用 “AI 辅助润色” 策略,将 AI 生成内容与人类写作混合,导致检测工具难以识别。例如,刘晨曦用 GPT-4 润色的哲学论文,在 Turnitin 中 AI 率仅为 34%。

- 新型模型生成内容:ChatGPT-4.5 生成的文章,在部分工具中 AI 率仅为 10%,说明检测模型可能落后于生成技术迭代。

💡 应对策略:如何选择最适合的 AI 查重工具

1. 根据使用场景选择工具

- 学术场景:优先选择 Turnitin 或知网。前者对纯 AI 生成内容检测严格,但需注意混合内容的误判风险;后者依托学术数据库,适合检测论文中的文献引用和专业术语。

- 自媒体与企业场景:朱雀大模型检测更具优势,其双链路检测能有效识别营销文案、新闻稿等非学术类内容的 AI 痕迹,同时对图片检测也有较好支持。

- 个人用户:若预算有限,可使用免费工具如 GPTZero,但需注意其对复杂内容的检测准确率较低。

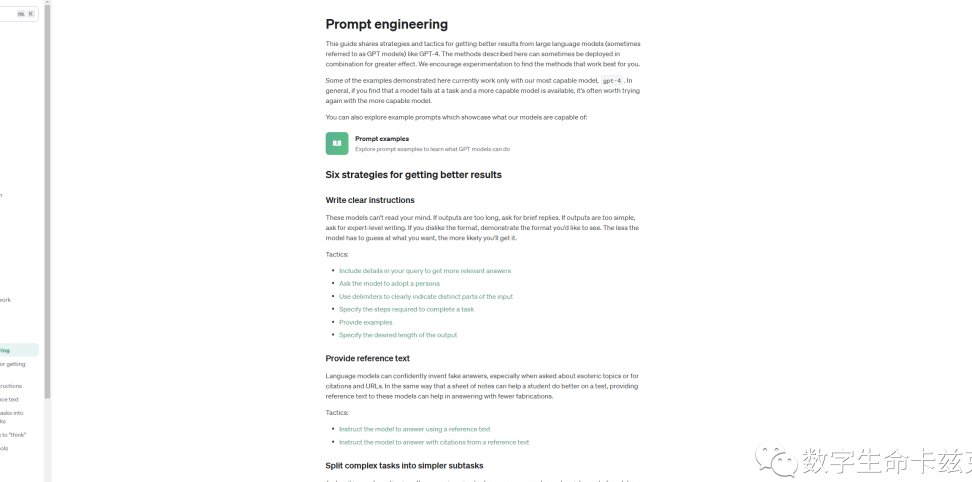

2. 降低误判风险的实用技巧

- 调整写作风格:避免使用 “引言 - 三点论证 - 结尾” 的模板化结构,适当加入口语化表达和非逻辑性插话。例如,在学术论文中穿插研究过程中的思考波折,可降低被误判的概率。

- 人工干预检测:若检测结果异常,可将文本提交至多个平台交叉验证。例如,李同学通过切换平台,发现自己的论文在学校指定平台 AI 率超标,但在其他平台检测合格。

- 合理使用 AI 工具:润色时避免整段依赖 AI,可采用 “AI 生成初稿 + 人工深度改写” 的模式。例如,刘晨曦在使用 GPT-4 润色后,会手动调整句式复杂度和用词多样性,将 AI 率从 51% 降至可接受范围。

3. 未来趋势:技术升级与行业规范

🔗立即免费注册 开始体验工具箱 - 朱雀 AI 味降低到 0%- 降 AI 去 AI 味