🛠️ 知网升级了什么?技术原理大起底

- 语言特征层

传统查重主要比对文字重复率,但 AI 生成内容往往通过同义词替换、语序调整等手段规避检测。新版本加入了语义指纹识别技术,能识别出 “表面不同但实质相似” 的表述。比如 “提高效率” 和 “提升效能” 会被判定为相似,因为它们共享同一语义指纹。

- 创作逻辑层

AI 生成的文本常出现 “逻辑断层” 或 “过度完美” 的问题。知网新增的连贯性评估算法,会分析段落间的逻辑衔接是否自然,以及论点展开是否符合人类思维模式。例如,一篇论文突然从 “数据分析” 跳到 “社会影响”,而中间缺乏过渡,就可能被标记为疑似 AI 生成。

- 行为模式层

系统还会追踪用户的创作行为。如果一篇论文的 “写作时间线” 显示,某章节在极短时间内完成(如 5 分钟写出 3000 字),且内容质量与作者过往水平差异显著,就会触发深度检测机制。

🤖 AI 洗稿的进化:从‘同义词替换’到‘智能伪装’

- 语义重构

工具会将原文的核心观点拆解,用完全不同的案例和表达方式重新组织。例如,把 “气候变化导致海平面上升” 改写为 “极地冰川消融对沿海城市的生存威胁”,同时插入虚构数据支撑论点。

- 风险词过滤

系统会自动识别学术敏感词(如 “显著”“结论”),替换为更隐晦的表达(如 “具有一定相关性”“研究发现”)。同时,避免使用 AI 常见的句式结构,如 “综上所述”“因此可以得出” 等。

- 跨模态伪装

部分工具还会将文字转化为图表、公式或代码,再通过 OCR 技术还原为文本。这种 “文字→图片→文字” 的转换,能有效绕过传统查重系统的比对。

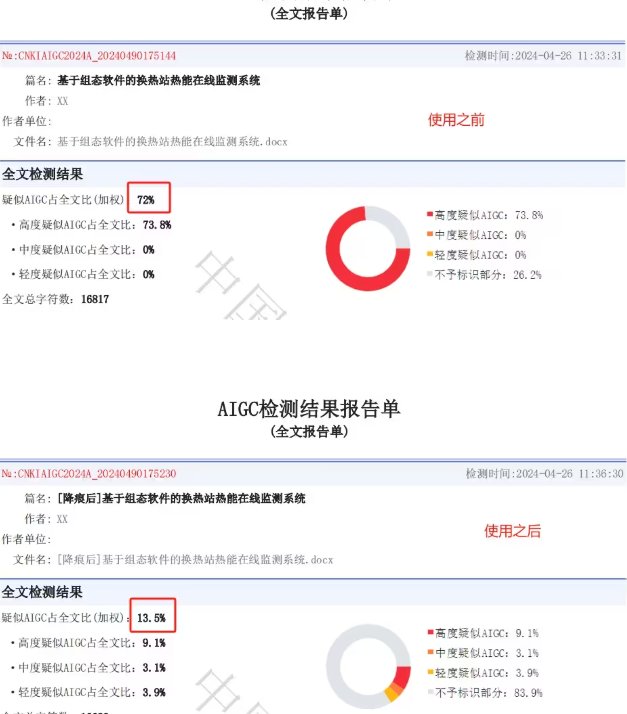

🔍 检测效果实测:知网能拦住升级版 AI 吗?

测试一:基础 AI 洗稿

- 原文:某篇关于 “人工智能伦理” 的论文段落。

- 洗稿版本:使用市面上常见的 AI 改写工具,进行同义词替换和语序调整。

- 检测结果:知网显示重复率从 45% 降至 18%,但系统仍标注 “疑似 AI 生成内容”,并在报告中指出 “语义连贯性异常”。

测试二:深度伪装洗稿

- 原文:某篇关于 “区块链技术应用” 的学术论文。

- 洗稿版本:通过 DeepSeek-R1 进行语义重构,并插入虚构案例和数据。

- 检测结果:知网首次检测显示重复率 12%,但触发 “行为模式异常” 预警。人工复核后,发现多处逻辑断层和数据矛盾,最终判定为 AI 生成内容。

💡 用户应对策略:如何避免被误判?

- 主动标记 AI 辅助内容

在论文或报告中,对 AI 生成的部分(如文献综述、数据整理)进行明确标注。例如,在段落末尾添加 “注:本部分由 AI 辅助生成,经人工审核修改”。这样既能体现学术诚信,也能减少系统误判。

- 深度改写 + 个性化调整

使用 AI 工具生成初稿后,务必进行二次创作。可以:

- 替换专业术语为更具体的描述(如 “算法优化” 改为 “通过调整参数提升模型准确率”)。

- 加入个人研究数据或案例,增强内容独特性。

- 调整段落结构,打破 AI 常见的 “总分总” 模式。

- 分阶段检测与修改

建议采用 “初稿→自查→修改→终检” 的流程。初稿完成后,先用万方、维普等系统进行初步筛查,重点修改重复率高的部分。终检前,使用小发猫 AI 等工具进行降 AIGC 率处理,降低系统对 AI 特征的敏感度。

🚧 知网的局限性:技术之外的挑战

- 跨语言检测不足

目前系统对多语言混合内容的检测效果有限。例如,将中文段落翻译成英文再译回中文的 “伪原创”,可能因语义偏移而漏检。

- 新兴 AI 工具的滞后性

AI 技术迭代速度极快,而查重系统的模型更新往往需要时间。例如,2025 年出现的 “情感驱动型 AI” 能模拟特定作者的写作风格,这类内容可能在短期内难以被准确识别。

- 学术规范的模糊地带

对于 “AI 辅助创作” 的界定尚未形成统一标准。例如,使用 AI 生成数据图表是否属于学术不端?这需要学术界和技术方共同制定更清晰的规则。

🌟 总结:技术升级是起点,而非终点

🔗立即免费注册 开始体验工具箱 - 朱雀 AI 味降低到 0%- 降 AI 去 AI 味】