? 2025 新版 ChatGLM 升级亮点:高效多轮交互与行业定制能力解读

? 高效多轮交互:让对话更流畅、更智能

ChatGLM2-6B 引入了Multi-Query Attention(MQA)技术,这一技术显著提升了推理速度和显存效率。与初代模型相比,推理速度提升了 42%,在 INT4 量化下,6G 显存支持的对话长度由 1K 提升到了 8K。此外,基于 FlashAttention 技术,模型的上下文长度从 2K 扩展到了 32K,在对话阶段使用 8K 上下文长度训练,使得模型能够处理更长、更复杂的对话场景。

为了验证升级后的性能,官方发布了 LongBench 数据集,这是一个专门针对长文本理解能力的评测数据集,包含 13 个英文任务、5 个中文任务和 2 个代码任务,覆盖单文档 QA、多文档 QA、摘要、Few-shot 学习等多个场景。测试结果显示,ChatGLM2-6B-32K 在同量级开源模型中表现突出,知识库调用质量提高了 20% 以上,避免了大量无效输出。例如,在处理一篇万字长文时,模型能够准确理解上下文,生成连贯且有价值的回答,而不会出现信息断层或重复的问题。

高效多轮交互不仅体现在技术层面,更直接影响用户体验。以智能客服为例,传统客服系统在处理复杂问题时,往往需要用户多次重复信息,导致效率低下。而升级后的 ChatGLM 能够在多轮对话中保持上下文一致性,快速理解用户需求,提供精准的解决方案。例如,在某健康咨询平台上,引入 ChatGLM 后,用户咨询的响应时间缩短了 80%,回答准确率高达 90% 以上,用户满意度显著提升。

? 行业定制能力:深度适配垂直领域需求

珠海华发金融科技研究院基于 ChatGLM 开发了风险点自动检测识别系统,通过构建语义理解规则库和历史风控知识库,结合模型的自然语言处理能力,大幅提升了风险识别的精度和效率。在处理大额贷款申请时,系统能够快速分析客户的财务状况、信用历史等多维度信息,自动生成风险点辅助决策意见,减少了人工审核的误判率。四川农商联合银行则利用 ChatGLM 构建了智能信贷系统,通过 “小模型 + 大模型” 框架,精准解析复杂信贷材料,信贷材料综合识别率跃升至 85% 以上,报告自动生成时间从数天缩短至数小时。

在医疗领域,ChatGLM 的行业定制能力同样表现出色。北京清华长庚医院开发的急性卒中辅助诊断工具,基于电子病历信息、头颅 CT 平扫数据和放射科医师报告,结合指令微调和 LoRA 技术,在内部验证集中急性卒中识别准确率高达 99.0%,大血管闭塞识别准确率达 80.0%。此外,某医院的智能随访系统通过 ChatGLM 实现了对 4630 余名人工耳蜗植入患者的服务覆盖,随访时间从平均 40 分钟 / 次缩短至 10 分钟 / 次,患者满意度提升至 95%,医生随访工作量减少 30%。

四川省气象探测数据中心联合和鲸科技,基于 ChatGLM 构建了气象数据查询智能体应用。该智能体整合了卫星、雷达、地面观测等多源气象数据,通过自然语言交互实现了数据查询、可视化展示和报告生成的全流程闭环。业务人员单次查询平均耗时从数小时压缩至分钟级,显著提升了灾害预警响应速度和农业调度精准度。

?️ 行业定制的实现路径:从数据到模型

行业定制的第一步是准备高质量的领域数据。例如,在医疗领域,需要收集大量的病历、检查报告等文本数据,并进行清洗和标注。以急性卒中诊断工具为例,研究团队使用了 2016 至 2024 年间 1,885 例患者的数据进行训练和验证,确保模型能够准确理解医疗术语和临床场景。

- P-Tuning v2:这是一种高效的微调方法,通过在模型的 Embedding 和每一层前添加新的参数,实现对特定领域的适配。例如,在广告文本生成任务中,使用 P-Tuning v2 微调 ChatGLM2-6B,能够生成更符合行业需求的广告文案,BLEU 和 ROUGE 指标显著提升。

- LoRA(Low-Rank Adaptation):通过在模型中引入低秩矩阵,仅训练少量参数即可实现模型的微调。某健康咨询平台采用 LoRA 技术对 ChatGLM 进行微调后,模型在健康问题回答的准确率和个性化服务方面都有明显提升。

模型微调完成后,需要将其部署到实际应用环境中。ChatGLM 支持多种部署方式,包括本地部署和云端部署。例如,四川气象的智能体应用在数据中心本地部署了 32B ChatGLM 基座模型与轻量化模型搭配的组合方案,确保了数据的安全性和响应速度。此外,ChatGLM 还提供了灵活的 API 接口,方便与现有系统集成,如智能客服系统、金融风控平台等。

? 未来展望:AI 与行业的深度融合

- 多模态融合:除了文本,ChatGLM 将逐渐支持图像、语音等多模态数据的输入和处理,进一步提升模型的综合理解能力。例如,在医疗领域,结合 CT 图像和文本报告进行分析,能够更准确地辅助诊断。

- 端侧推理优化:通过优化模型架构和量化技术,ChatGLM 将在端侧设备上实现更高效的推理,降低对云端算力的依赖。例如,某智能客服系统采用 ChatGLM-6B-INT4 模型,在消费级显卡上即可实现毫秒级响应。

- 教育领域:ChatGLM 可用于智能辅导系统,根据学生的学习情况提供个性化的学习建议和解答。

- 物流领域:通过分析物流数据和用户需求,优化配送路线和预测货物运输时间。

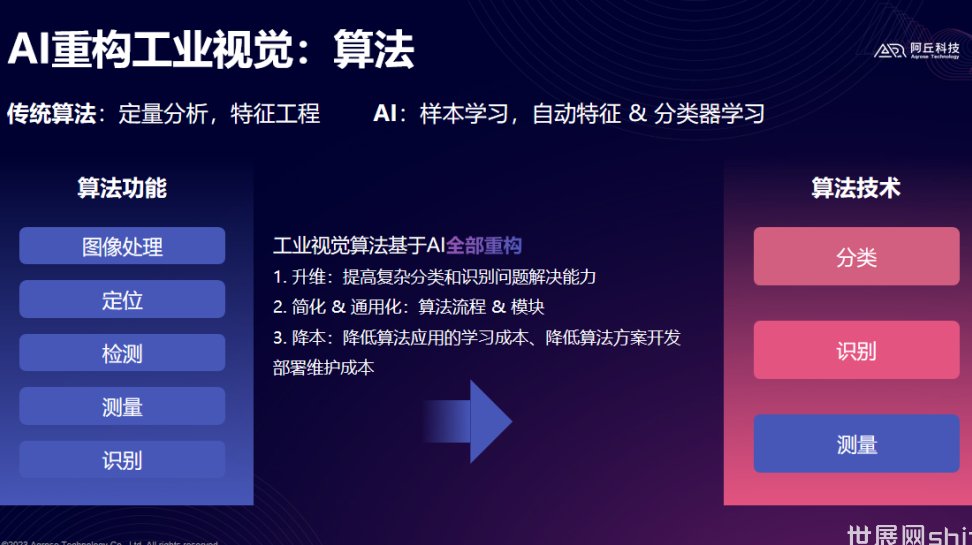

- 工业领域:结合工业物联网数据,实现设备故障预测和智能维护。