做动漫的朋友都知道,配音这事太关键了。角色的声音直接影响观众代入感,要是声音生硬、情感不对味,剧情再好也容易出戏。以前找专业配音演员,成本高、周期长,尤其是小众语种或者需要特殊声线的角色,找合适的人难如登天。这两年 AI 音频生成平台火起来后,大家都想试试能不能解决这些痛点。但市面上平台那么多,到底哪个靠谱?今天就来好好唠唠,尤其是 DubbingX 为啥能在动漫圈圈粉无数。

先把目前市面上常见的几个平台摆出来聊聊。DeepVoice 算是老牌选手了,早期靠深度学习技术出圈,支持多种语言合成,基础音质还行。但用下来发现,它的情感表达比较单一,配日常对话还行,要是碰到需要激烈情绪或者细腻情感的戏份,声音就显得有点死板,像机器人念经似的。而且它的角色定制功能不够灵活,想给某个动漫角色设计独特声线,调整参数特别麻烦,得反复试错,效率不高。

说完其他平台,重点来看看 DubbingX。首先最让人惊艳的就是它的高精度 TTS 技术,也就是文本到语音合成技术。传统 TTS 容易让声音听起来机械、生硬,但 DubbingX 用了多层神经网络模型,不仅能准确还原文字的发音,还能捕捉到语句中的情感波动。比如配一句 “你为什么要这样做?”,生气的语气和悲伤的语气,它能通过声调、语速的细微变化区分得很清楚,听起来就像真人配音演员在演绎一样。

现在动漫市场越来越全球化,很多作品需要推出多国语言版本。DubbingX 在这方面简直是 “全能选手”,它支持超过 50 种语言和方言,从常见的英语、日语、韩语,到比较小众的荷兰语、瑞典语,甚至一些少数民族语言,都能轻松合成。而且每种语言都做了深度优化,比如日语的助词发音、韩语的敬语表达,它都能准确处理,不会出现 “洋腔洋调” 的情况。之前有部国产动漫在海外上线时,需要同时推出英语、日语、法语三个版本的配音,用 DubbingX 不仅节省了大量找外籍配音演员的成本,还保证了配音质量,上线后反响很好。

动漫制作周期通常都很紧张,尤其是遇到临时改台词或者加急补配音的情况,时间就是生命。DubbingX 的生成速度堪称 “闪电级”,一段 10 分钟的文本,上传后几乎秒级生成音频,而且支持批量处理。比如一部 24 集的动漫,每集有 30 分钟的配音内容,用 DubbingX 可以同时生成多个角色的音频,大大缩短了制作周期。之前有个动漫团队在制作过程中,突然接到甲方要求,需要在 3 天内完成全部配音,换做以前根本不可能,但用了 DubbingX 后,居然按时完成了任务,简直是救命稻草。

先说国内的 “星漫动画”,他们去年制作的一部校园题材动漫,里面有多个性格迥异的角色,光主角就有 5 个。以前用传统配音方式,光选配音演员就花了一个月,还经常因为演员档期问题耽误进度。后来尝试用 DubbingX,先给每个角色定制了专属声线,比如活泼的女主角声音清亮、语速快,内向的男主角声音低沉、语速慢,生成的配音非常贴合角色设定。而且在后期修改台词时,直接在平台上调整文本就能生成新的音频,不用再麻烦配音演员返工,整个项目周期比以往缩短了 40%,成本也降低了 30%。

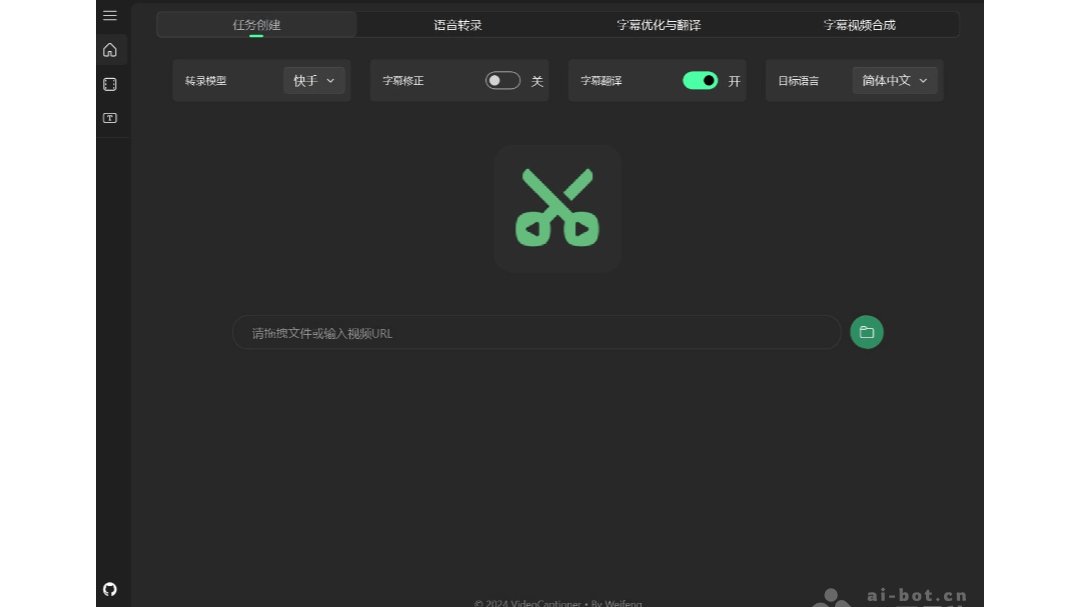

说了这么多优势,再给大家讲讲怎么用 DubbingX。首先,注册登录平台后,会看到一个简洁的操作界面。第一步,点击 “创建项目”,给项目起个名字,比如 “XX 动漫配音项目”。第二步,添加角色,点击 “新建角色”,可以上传参考音频,也可以直接在平台提供的声线库中选择基础声线,然后根据角色设定调整参数,比如音色、音调、语速、情感强度等,调整完后点击 “保存角色”。

随着技术的不断进步,AI 音频生成平台在动漫行业的应用只会越来越广泛。未来,可能会出现更智能的角色声线学习功能,比如平台能自动分析大量动漫作品中的角色配音,建立更丰富的声线库,用户直接搜索就能找到类似的声线,省去手动调整参数的时间。而且,情感表达可能会更加细腻,不仅能区分喜怒哀乐,还能捕捉到犹豫、惊讶、嘲讽等更复杂的情感。