🛠️ AI 内容检测的核心技术解析

1. 统计特征分析法

人类写作的词汇分布往往符合 Zipf 定律,高频词和低频词的比例相对稳定。而 AI 生成的文本可能出现异常偏差,比如高频词过度集中或低频词缺失。通过计算 “词频分布拟合误差”,可以量化这种差异。例如,人类文本的功率谱通常呈现 1/f 噪声特征,而 AI 生成文本可能在特定频率出现异常峰值。

2. 熵与复杂度分析

从信息论角度看,AI 生成的文本条件熵较低,因为模型在生成时确定性较高。比如,人类写作可能会有更多随机的语法变化和语义跳跃,而 AI 更倾向于选择概率最高的词汇组合。另外,AI 文本的排列熵(序列模式多样性)通常低于人类,这可以通过排列熵算法进行量化检测。

3. 语言模型困惑度计算

困惑度(Perplexity)是评估语言模型对文本预测能力的指标。对于 ChatGPT 生成的文本,其困惑度通常较低,因为模型对自己生成的内容预测准确率更高。计算公式为:

当困惑度低于某个阈值时,系统会判定文本可能由 AI 生成。

🧪 主流检测工具对比与实测

1. GPTZero:学术场景的黄金标准

由普林斯顿大学开发的 GPTZero,采用七组件检测模型,能从词汇集中度、句子长度分布等多个维度分析文本特征。在测试中,它对 ChatGPT 生成的学术论文识别准确率超过 90%,但对非英语内容的检测效果稍弱。免费版支持单次检测,付费版可批量处理文件并提供 API 接口,适合教育机构和期刊编辑使用。

2. 朱雀 AI 检测:中文内容的精准猎手

腾讯推出的朱雀 AI 检测在中文场景表现突出,尤其擅长识别文心一言、混元等国产模型生成的内容。其核心优势在于使用 140 万份正负样本进行训练,对中文语境下的句式结构、标点使用等特征捕捉精准。实测显示,它对混合编辑的中文文本检测准确率达 95% 以上,但对诗歌等特殊文体的识别仍需优化。

3. MitataAI 检测器:智能改写与检测一体化

MitataAI 的独特之处在于 “检测 + 降重” 双功能。它不仅能识别 40 多种语言模型生成的内容,还支持 10 级强度的 AI 痕迹净化功能。例如,将一篇 AI 率 16% 的论文通过其 “语义重构技术” 处理后,AI 特征值可降至 6.8%,同时保留核心论点。对于需要平衡原创性和效率的创作者来说,这是个实用工具。

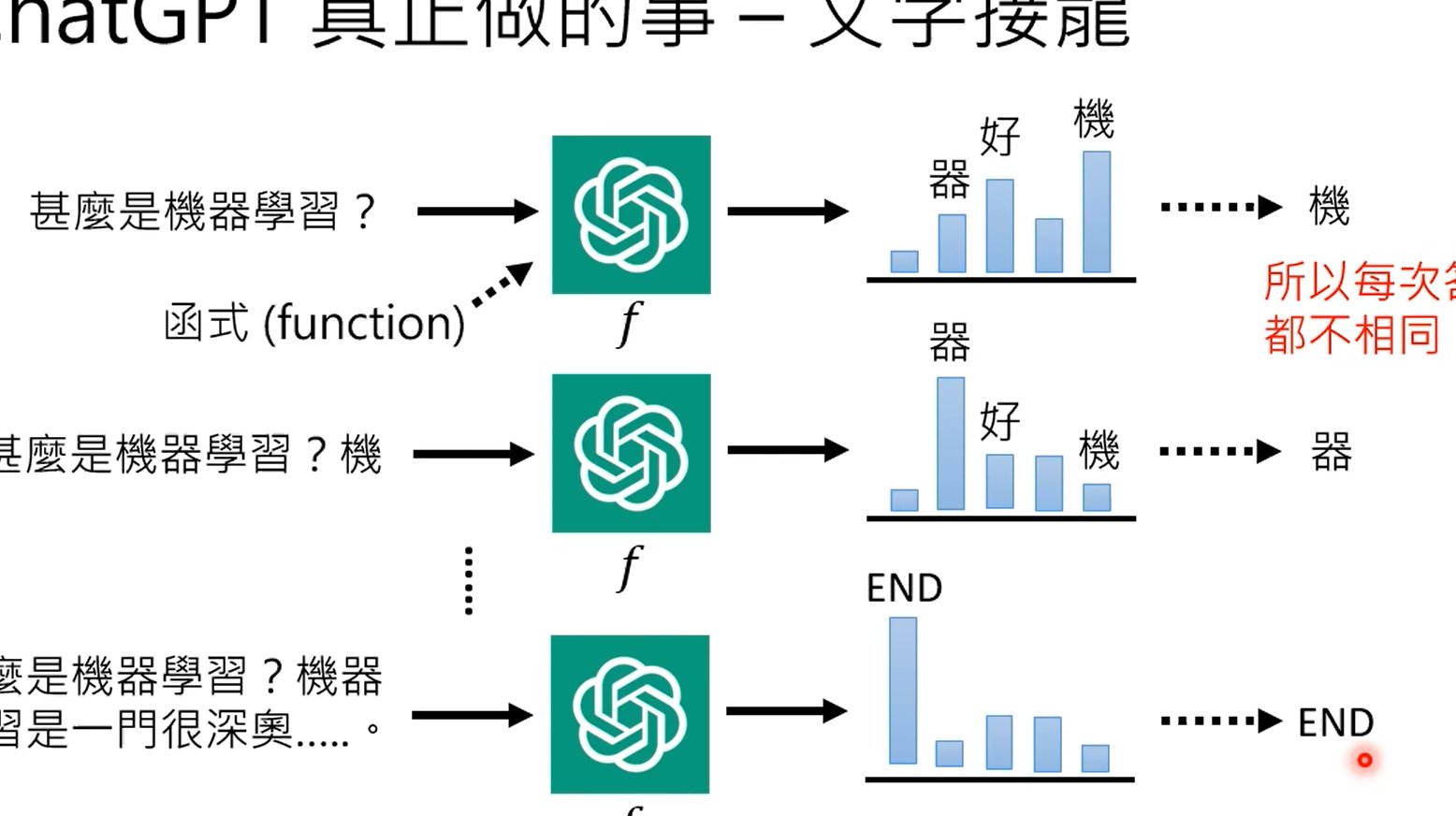

🧩 ChatGPT 概率计算的底层逻辑

1. 模型指纹检测

不同版本的 ChatGPT 在生成文本时会留下独特的 “指纹”。例如,GPT-3.5 和 GPT-4 在 Top-k 采样、温度参数设置上的差异,会导致文本概率分布的细微不同。通过对比这些特征,检测工具可以溯源到具体的生成模型。

2. 对抗性输入测试

向模型输入特定的 “对抗样本”(如添加微小扰动的文本),观察输出变化。例如,在句子中插入不影响语义的虚词,人类可能无感,但 ChatGPT 的输出概率会显著波动。这种方法能有效识别 AI 生成内容,但需要一定的技术门槛。

3. 多模态联合检测

结合文本、图像、音频等多维度特征进行分析。例如,AI 生成的图像可能存在边缘模糊、频域异常等问题,而文本与图像的语义一致性也可以作为辅助判断依据。

💡 提高检测准确率的实用技巧

重要文档建议使用 2-3 款工具对比结果。比如先用 MitataAI 进行初筛,再用学校指定的知网检测系统复核,这样能将识别率提升 37%。

2. 动态改写策略

利用 MitataAI 的强度调节功能,分阶段降低 AI 特征值。例如,先选择 “轻度改写” 保留核心逻辑,再逐步提高改写强度以规避检测。

3. 特征监控法

定期检测自己的写作样本,建立个人风格基线。如果某篇文章的词汇多样性、句长分布等指标突然偏离基线,就可能存在 AI 辅助痕迹。

⚔️ 对抗样本与检测工具的博弈

目前,多模态检测、实时检测技术(如在生成过程中嵌入水印)成为新的研究热点。例如,某些工具通过在 Token 选择阶段植入概率分数作为水印,既能保证文本质量,又能实现溯源。

🚀 未来趋势:从检测到治理

- 实时检测:未来可能出现与写作工具深度集成的插件,在内容生成的同时进行实时风险提示。

- 跨语言检测:针对多语言混合内容的检测算法将不断优化,减少对特定语种的依赖。

- 伦理治理框架:检测结果将与内容标注、版权追溯等功能结合,形成完整的 AIGC 治理生态。

🔗 立即免费注册 开始体验工具箱 - 朱雀 AI 味降低到 0%- 降 AI 去 AI 味 🔗

(https://www.diwuai.com?inviteCode=8f14e45f)