🔍 朱雀大模型检测漏洞案例分析:vLLM 修复经验分享

在 AI 大模型快速发展的当下,模型的安全性和稳定性成为企业和开发者关注的焦点。最近,腾讯朱雀实验室发现了朱雀大模型在推理框架 vLLM 中存在的严重漏洞,并协助 vLLM 团队完成修复。这一案例不仅揭示了大模型应用中的潜在风险,也为行业提供了宝贵的修复经验。

🔍 漏洞发现:PyNcclPipe 服务的致命缺陷

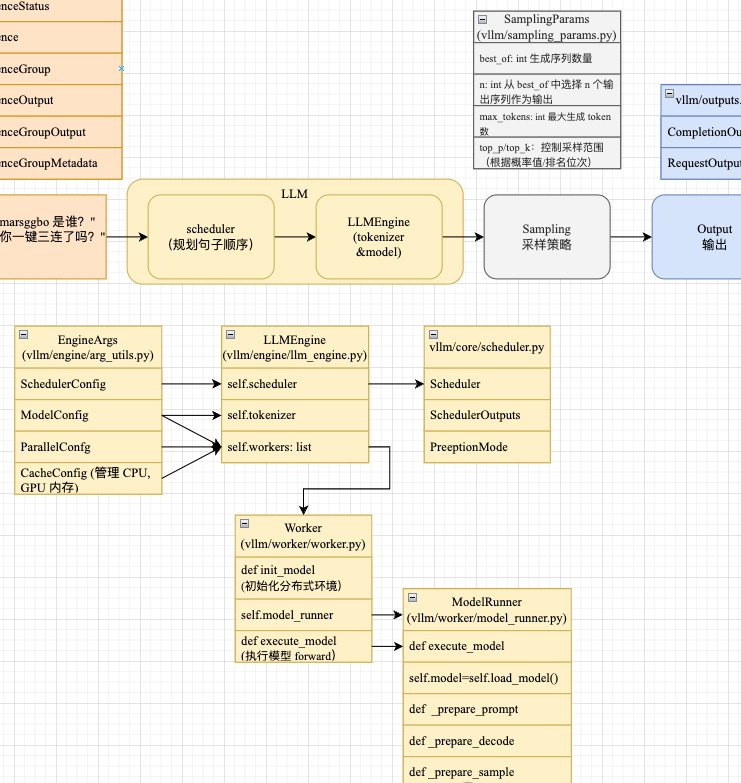

朱雀实验室在对朱雀大模型的安全评估中,通过 AI 自动化代码审计结合人工验证,发现 vLLM 的 PyNcclPipe 服务存在严重的安全漏洞。这个服务主要负责分布式 GPU 节点间的高效数据传输,原本是提升推理性能的关键组件,却因设计缺陷成为攻击者的突破口。

当 PyNcclPipe 服务接收到外部恶意客户端发来的不安全数据流时,会触发 pickle 反序列化漏洞,导致远程命令执行(RCE)。攻击者可利用此漏洞控制服务器,窃取模型文件,甚至进一步渗透 GPU 算力集群等内网平台。更严重的是,该漏洞的 CVSS 评分高达 9.8 分,意味着攻击者无需复杂操作即可造成大规模数据泄露、算力窃取和服务中断等后果。

🚀 修复过程:从漏洞定位到版本更新

漏洞发现后,朱雀实验室迅速向 vLLM 开发团队提供了详细的技术分析和复现步骤。vLLM 团队高度重视,立即启动修复流程。经过深入分析,他们确定漏洞的根源在于 pickle 反序列化的不安全使用,以及对外部输入数据的验证不足。

vLLM 团队采取了以下修复措施:一是改进 PyNcclPipe 服务的输入验证机制,增加对数据流的合法性检查;二是替换不安全的 pickle 序列化方法,采用更安全的数据传输协议;三是限制 PyNcclPipe 服务的网络访问权限,默认关闭外部可访问端口。经过多轮测试和验证,vLLM 在 0.8.5 版本中正式修复了该漏洞,并在官方公告中致谢朱雀实验室。

🛠️ 工具支持:AI-Infra-Guard 助力漏洞自查

为了帮助 vLLM 社区和企业快速评估现有系统是否受漏洞影响,朱雀实验室在开源工具 AI-Infra-Guard 中新增了对该漏洞的扫描功能。用户只需运行该工具,即可自动检测服务器代码是否调用了 PyNcclPipe 模块,并核查相关服务端口的访问权限。

AI-Infra-Guard 是朱雀实验室推出的一款全面的 AI 基础设施安全评估工具,支持检测 30 多种 AI 组件的漏洞,包括 vLLM、ComfyUI、Ollama 等。它不仅能快速定位漏洞,还能提供详细的修复建议,帮助开发者及时采取措施。目前,该工具已入选 DeepSeek 官方推荐应用清单,成为大模型安全领域的重要工具。

💡 经验总结:大模型安全的三道防线

通过这次漏洞修复案例,我们可以总结出大模型安全的三个关键经验:

主动防御:常态化安全评估

企业应建立常态化的安全评估机制,定期对大模型的推理框架、组件和服务进行全面检查。朱雀实验室通过自动化审计和人工验证相结合的方式,能够及时发现潜在漏洞,避免风险积累。

技术升级:选择安全可靠的框架

在选择大模型推理框架时,不仅要关注性能指标,还要考虑其安全性和社区支持度。vLLM 作为高性能的推理框架,在修复漏洞后进一步提升了安全性,成为企业级应用的可靠选择。

工具赋能:利用开源工具提升效率

AI-Infra-Guard 等开源工具为开发者提供了便捷的漏洞检测和修复支持。通过合理使用这些工具,企业可以快速响应安全事件,降低安全运维成本。

🌟 未来展望:构建更安全的 AI 生态

随着大模型应用的不断扩展,安全问题将成为行业发展的重要挑战。朱雀实验室表示,将继续加强对大模型基础设施的安全研究,推动更多安全工具的开源和普及。vLLM 团队也承诺,将持续优化框架的安全性,为用户提供更可靠的服务。

对于开发者和企业来说,关注大模型的安全动态,积极参与社区协作,是保障 AI 应用安全的关键。通过借鉴朱雀实验室和 vLLM 团队的经验,我们可以共同构建一个更安全、更可信的 AI 生态。

该文章由

diwuai.com第五 ai 创作,第五 AI - 高质量公众号、头条号等自媒体文章创作平台 | 降 AI 味 + AI 检测 + 全网热搜爆文库

🔗立即免费注册 开始体验工具箱 - 朱雀 AI 味降低到 0%- 降 AI 去 AI 味