? Llama 4 技术解析:MoE 架构与多模态突破

? 性能实测:理想与现实的差距

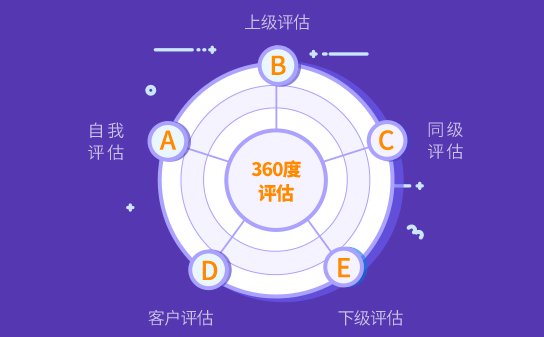

? 企业级 AI 模型选择核心指标

1. 多模态能力匹配度

- 文本处理:测试模型在专业领域(如法律、金融)的语义理解和生成能力,例如让其分析合同条款或撰写财报摘要。

- 图像 / 视频分析:验证模型是否支持细粒度识别(如医学影像中的病灶定位)或时序理解(如视频中的事件序列分析)。

- 跨模态融合:考察模型能否将图文信息结合生成结构化输出,例如根据产品图片自动生成多语言产品描述。

2. 推理效率与成本

- 硬件需求:确认模型在企业现有 GPU 集群上的运行效率。例如,Llama 4 Scout 在单个 H100 上即可运行,而 DeepSeek V3 可能需要多卡协作。

- 响应速度:测试不同并发量下的延迟表现,避免在高负载场景中出现服务卡顿。

- 长期成本:考虑模型迭代频率和授权费用。开源模型(如 Llama 4)虽初期成本低,但需投入人力进行维护;闭源模型(如 Claude 3)通常提供更稳定的技术支持。

3. 数据安全与合规

- 隐私保护:确保模型支持联邦学习或机密计算,避免企业敏感数据泄露。例如,绿盟科技的 AI 大模型风险评估工具可检测数据泄露风险,并提供整改建议。

- 内容合规:通过对抗攻击测试,验证模型能否抵御恶意输入(如诱导生成虚假信息)。红杉中国的 xbench 工具提供了多维度的安全评估指标,帮助企业识别潜在风险。

4. 工具链与生态支持

- 开发工具:检查模型是否提供完善的 API、SDK 及开发文档。例如,Meta 为 Llama 4 提供了与 PyTorch 深度集成的工具链,降低了二次开发门槛。

- 行业适配:优先选择已在目标行业有成功案例的模型。例如,Llama 4 在医疗领域可辅助病历分析,而 Claude 3 在金融风控场景中表现突出。

?️ 选型实战:从测试到落地的完整流程

- 场景拆解与需求文档

- 明确业务目标,例如 “提升客服响应效率” 或 “优化供应链预测”。

- 列出关键指标,如准确率、响应时间、成本预算等。

- 模型初选与对比测试

- 根据需求筛选 3-5 款候选模型,包括开源(如 Llama 4)和闭源(如 Claude 3)方案。

- 使用企业自有数据进行盲测,重点关注长尾场景(如罕见病诊断、极端市场波动)。

- 压力测试与安全评估

- 在模拟生产环境中测试模型的稳定性,例如通过高并发请求验证吞吐量。

- 委托第三方机构进行安全审计,确保符合 GDPR、等保 2.0 等合规要求。

- 成本效益分析

- 对比硬件采购、人力维护、授权费用等综合成本。

- 评估 ROI,例如计算自动化客服节省的人力成本与模型部署成本的平衡点。

- 分阶段部署与迭代

- 先在非核心业务中试点,如内部知识库查询,再逐步扩展至关键流程。

- 建立反馈机制,持续收集用户意见并优化模型参数。

⚠️ 避坑指南:常见陷阱与应对策略

- 宣传夸大:要求厂商提供未优化的原始测试数据,或通过第三方平台(如 Hugging Face)获取中立评测结果。

- 生态缺失:优先选择生态活跃的模型,例如 Llama 4 在 GitHub 上拥有数千个社区贡献的微调脚本,而小众模型可能面临维护难题。

- 技术锁定:避免过度依赖单一厂商,可采用混合架构,例如用 Llama 4 处理文本、GPT-5 生成图像,通过中间件实现协同工作。

? 未来趋势:智能体与行业深度融合

Llama 4 的发布标志着开源多模态模型进入新阶段,但其实际表现与宣传的差距提醒企业:AI 选型需回归业务本质。通过场景化测试、多维度评估和分阶段落地,企业既能享受开源模型的低成本优势,又能规避技术风险。未来,随着智能体架构的普及,灵活组合高性能模型将成为企业智能化升级的关键策略。