最近总被身边朋友问:“我论文拿去检测,为啥两次结果差那么多?”“AI 检测到底是怎么判断抄袭的?” 作为跟各类检测系统打交道多年的人,今天就掰开揉碎了跟大家聊聊论文 AI 检测这点事 —— 从原理到数据库,再到结果波动的关键原因,全是干货。

📌论文 AI 检测核心原理:不是 “找一模一样”,而是 “抓语义关联”

很多人觉得论文 AI 检测就是简单比对文字,只要改改语序、换几个词就行?大错特错!现在的检测系统早就不是 “傻白甜” 了。

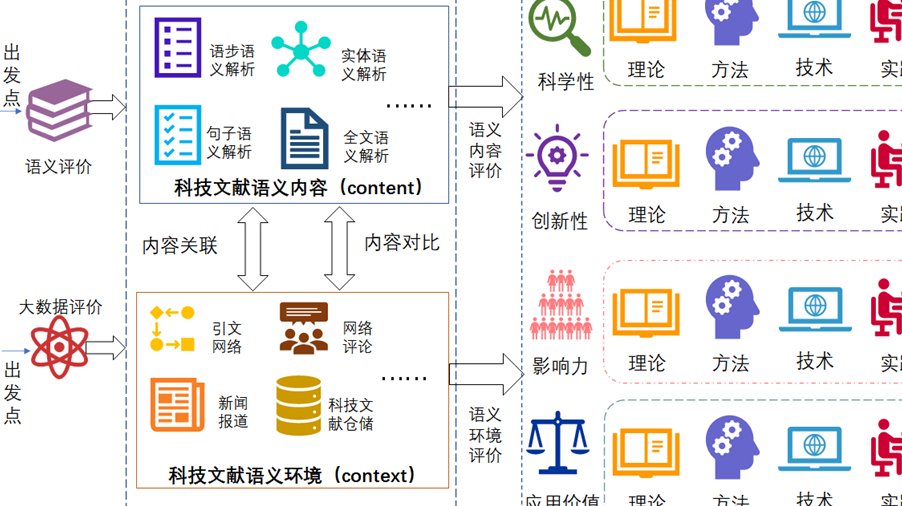

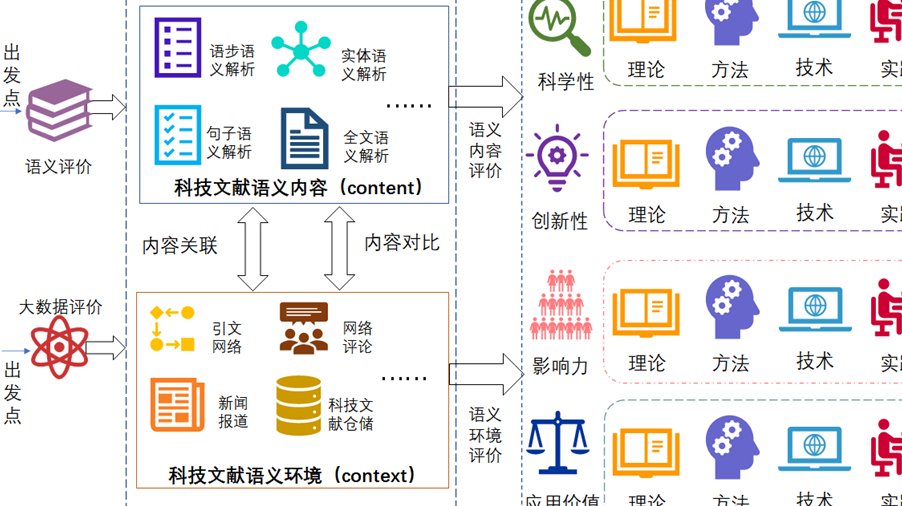

核心原理分两步:文本特征提取和语义相似度计算。先把待检测论文拆成一个个 “语言碎片”—— 可能是词组、句子,甚至是段落逻辑。就像给文章拍 X 光,把骨架(逻辑结构)和血肉(具体表述)都拆解出来。然后,系统会拿这些碎片去跟数据库里的文献比对,不只是看文字是否重合,更会分析 “意思是不是一样”。比如 “人工智能推动科技发展” 和 “科技发展因人工智能而加速”,文字不同但语义高度相似,现在的系统一抓一个准。

还有个容易被忽略的点:上下文关联检测。以前的系统可能只看单句,现在会看前后文逻辑。比如你抄了某篇论文的一个案例,哪怕改了表述,但案例的分析逻辑、数据引用顺序和原文一致,系统也能识别出 “关联性异常”。这也是为什么单纯改词、换句序,现在越来越难蒙混过关。

🔍常用检测方法:从 “硬比对” 到 “软分析” 的升级

现在主流的检测方法,早就不是单一模式了,而是 “组合拳” 出击。

最基础也最核心的是片段比对法。系统会把论文切成若干个小片段(通常是 13-20 个字符),逐个跟数据库里的内容比对。如果某个片段在数据库里出现次数超过阈值,就会标红。这个方法的优势是快,但缺点是对 “长句改写” 敏感 —— 比如把长句拆成短句,可能就检测不出来?别高兴太早,现在系统会结合 “句群比对”,看几个短句组合起来的意思是不是和原文某段一致。

更高级的是语义向量法。简单说,就是给每句话生成一个 “语义密码”(向量),如果你的句子和数据库里某句的 “密码” 重合度高,就算文字不一样,也会被标记。比如 “机器学习通过数据训练优化模型” 和 “数据训练帮助机器学习模型提升性能”,语义向量几乎一致,跑不掉。

还有个冷门但重要的方法:引用规范检测。系统会自动识别论文里的引用部分,如果引用格式不规范(比如没标出处、标了出处但内容和原文重合度过高),就算是正常引用,也可能被算成重复。这也是为啥老说 “引用要规范,格式不能懒”。

📚检测系统数据库:不是 “万能库”,各有 “偏重点”

很多人以为所有检测系统的数据库都一样?错!不同系统的数据库差别大了去了,这也是为啥同篇论文在不同系统检测结果差很多的关键。

核心数据库是基础,基本都包含这几类:已发表的期刊论文、学位论文(本科、硕士、博士)、会议论文。这部分是 “标配”,但覆盖范围有差异。比如有的系统侧重文科文献,有的侧重理工科,如果你写的是交叉学科,可能在 A 系统检测重复率低,在 B 系统就高。

特色数据库是差异点。比如有的系统会收录 “网络资源库”—— 包括知乎、豆瓣、博客甚至公众号文章,如果你参考了这些内容又没标注,在这类系统里就容易中招。还有的系统有 “自建库”,比如某高校的检测系统,会把本校往年的论文加进去,防止本届学生抄学长学姐的。

要注意的是,数据库不是实时更新的。大部分系统的数据库更新周期是 1-3 个月,也就是说,你引用了刚发表半个月的论文,可能暂时检测不出来,但过段时间再测,结果就可能变。这也是为啥建议定稿前一周再测一次,避免 “漏网之鱼”。

📊检测结果影响因素:这些 “坑” 你可能踩过

“我明明没抄,为啥重复率还这么高?”“隔了三天再测,重复率涨了 5%?” 这都是有原因的,主要跟这几个因素有关。

数据库更新是头号原因。前面说了数据库会定期更新,如果你第一次检测时,某篇相关文献还没进库,第二次检测时刚好被收录,重复率自然会涨。见过最夸张的案例:有同学周一检测重复率 10%,周五再测变成 25%,就是因为期间系统加了一批新论文。

论文格式影响也很大。如果论文里的公式、图表、表格没规范排版(比如用图片格式插入),系统可能无法识别,把这些内容当成文本比对,导致重复率虚高。还有目录、参考文献格式乱码,系统可能会把这些部分算进正文检测,结果肯定不准。

相似度阈值设置不同。每个系统都有自己的 “判定标准”,有的系统连续 13 个字相同就算重复,有的是连续 15 个字;有的对语义相似的容忍度高(阈值 80%),有的比较严(阈值 60%)。比如你改了某句话,在 A 系统里没超过阈值不算重复,在 B 系统里就可能被标红。

引用内容处理方式也很关键。如果引用的内容超过了 “合理引用比例”(通常是单篇引用不超过 10%,整体引用不超过 20%),就算格式规范,也可能被算入重复。还有的同学引用时 “大段照搬”,只改了开头结尾,中间内容和原文几乎一样,系统会判定为 “过度引用”。

另外,检测片段的划分方式也会影响结果。有的系统按段落划分,有的按句子划分。如果你的论文段落长,刚好某段里有几个小片段和数据库重合,可能整个段落都被标红;而按句子划分的系统,可能只标红重合的句子,结果自然不同。

💡给大家的实用建议:避开检测 “雷区”

知道了原理和影响因素,就能有针对性地避坑。

首先,选对检测系统。如果学校用某款系统,就尽量用同款检测,别贪便宜用小众系统 —— 数据库不一样,结果参考意义不大。其次,定稿前留足检测时间,最好间隔一周测两次,避开数据库更新期。

然后,处理引用要 “双保险”:不仅格式要规范(标清楚作者、年份、出处),内容还要 “消化改写”—— 把原文意思用自己的话讲出来,别大段照搬。公式、图表尽量用系统能识别的格式插入,避免被误判。

最后,别信 “降重神器” 的噱头。那些号称 “一键降重” 的工具,大多是简单替换同义词、打乱语序,看似能降低重复率,但会让语句不通顺,而且现在的系统很容易识别这种 “机械降重”,反而可能标红更多。真正有效的降重,是理解原文后重新组织语言,这才是王道。

论文检测本质是为了保证学术诚信,不是 “找茬”。了解它的原理和规则,才能更有针对性地写论文,既避免重复,又保证质量。记住,系统是死的,人是活的 —— 摸透规则,才能轻松应对。